[讀者活動] Zillow 的 8.8 億美元學費:AI 轉型失敗的真相是管理,不是技術

The CEO's AI Dream, The CFO's Silent Scream.

過去幾年榜上有名的 AI 決策失誤,包括 Zillow、IBM、Amazon、Tesla 的失敗,從來都不是技術的失敗,而是管理者「心智模型」的失敗。這也不是 CEO 與 CFO 之間的零和博弈。

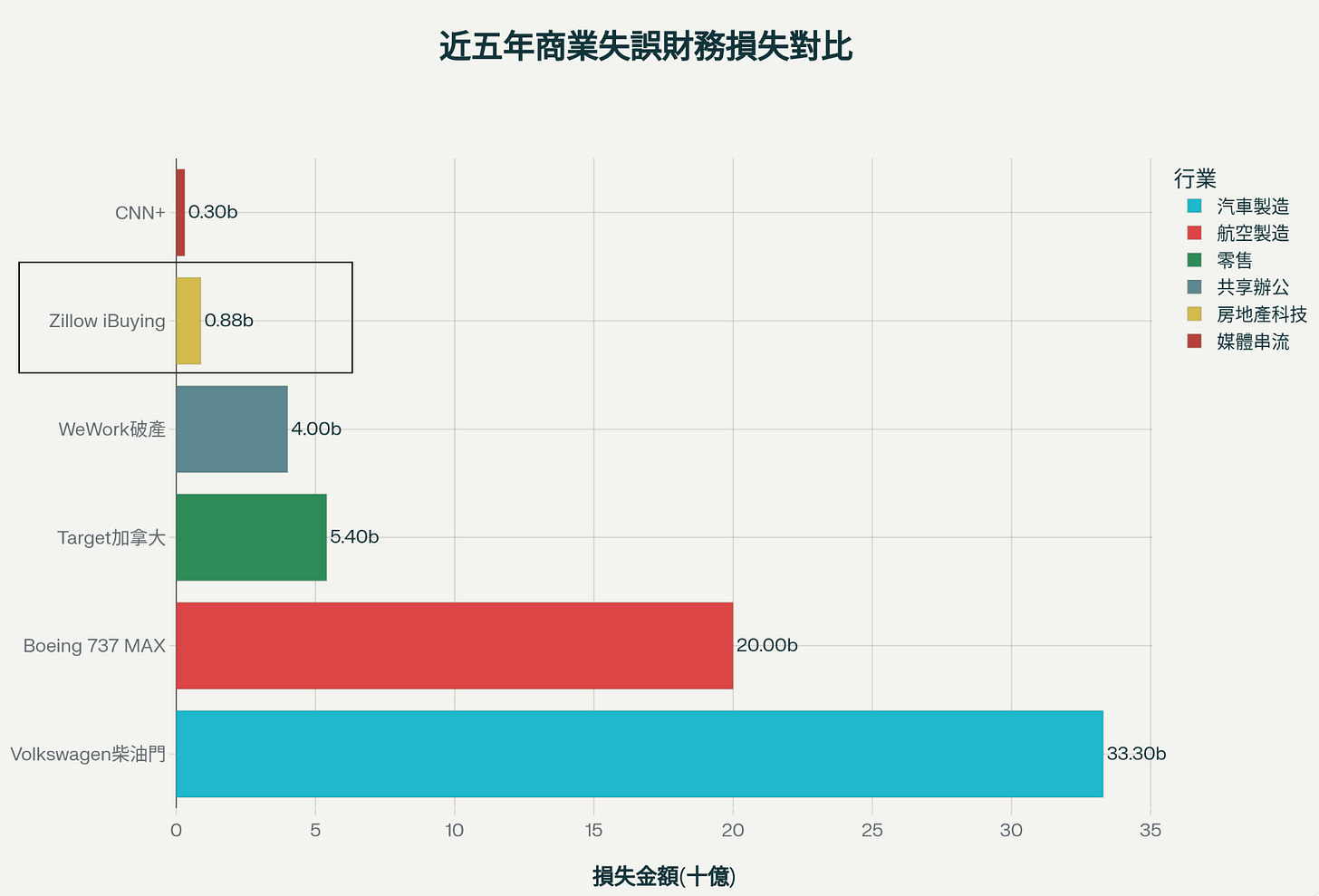

一方面,董事會和投資人都在問:我們的 AI 策略是什麼?我們什麼時候能用 AI 降本增效?另一方面,媒體頭條全是 Zillow 燒掉 8.8 億美元、IBM Watson 醫療 AI 淪為笑柄、Amazon 的 AI 招聘充滿偏見的災難。

所以,AI First 到底是一門 CEO 必修課,還是一個 CFO 必須避開的陷阱?

完了,你是不是也這麼想?覺得這像一場不知道該下注哪一邊的賭局?

但這根本不是選擇題。

這是一場關於「認知」的辯論。而這些失敗案例,就是 CFO 用來反駁 CEO 過度樂觀的最佳論據。

陷阱一:人機對立觀 —— CEO 的「效率」,CFO 的「負債」

CEO 可能會說:「我們用 AI 來自動化客服部門,三年內可以省下 50% 的人力成本!」

這時,一個好的 CFO 會問:「那 Cruise 自動駕駛因為管理文化問題導致的全面停擺、CEO下台,以及隨之而來的訴訟和聲譽損失,這筆『或有負債』我們算進去了嗎?」

許多專案始於一個傲慢的念頭:用 AI 指導甚至取代專家。但其本質是將組織的風險無限放大。

經典案例(AI 農夫 vs. 農民):一個精準灌溉系統試圖直接告訴經驗豐富的農民「何時該澆水」。這種「我比你更懂」的設計,理所當然地遭到了農民的棄用。只有當它轉變為提供專家未知數據的「儀表板」,AI 才從一個不受歡迎的老闆,變成了得力的助手。

CFO 的底線:當你追求用 AI「取代」人時,你得到的短期效率,可能會變成 CFO 資產負債表上長期的、災難性的負債。Tesla 將其輔助駕駛系統命名並市場行銷為「全自動駕駛」(Full Self-Driving),讓用戶過度信賴一個遠未成熟的系統,最終導致了數百起本可避免的致命事故,就是最好的證明。

陷阱二:數據萬能論 —— CEO 的「資產」,CFO 的「訴訟」

CEO 可能會說:「我們有海量用戶數據,這是我們的核心資產!讓 AI 來幫我們篩選最優質的客戶!」

CFO 的噩夢就是 SafeRent 的翻版。他會問:「如果我們的『最優質』標準,被證明系統性地歧視了特定族群,導致 SafeRent 那樣的 220 萬美元和解金和長期的獨立審計,這個法律風險在你的 ROI 計算裡嗎?」

Amazon 的 AI 招聘工具學習了公司過去十年的招聘數據,結果忠實地延續了對女性的偏見,系統性地給任何出現「女性 (women's)」字眼的履歷降分。

IBM Watson for Oncology 這個號稱能改變癌症治療的 AI,因主要使用紐約頂級癌症中心的數據進行訓練,其建議在全球其他醫療條件、人種基因、環境因素千差萬別的地方,往往水土不服,甚至有害。

SafeRent 的租戶篩選系統依靠信用歷史給租戶打分,卻無法理解「低收入住房券」的價值,從而系統性地歧視了少數族裔申請者,引發集體訴訟。

CFO 的底線:你以為的數據資產,很可能是未被發現的偏見負債。如果你的歷史數據充滿偏見,AI 就會成為你用來歧-視的最高效工具,還讓你自以為客觀,並最終讓你付出沉重的法律和財務代價。

陷阱三:複雜性謬誤 —— CEO 的「模型」,CFO 的「現實」

CEO 可能會說:「我們的模型比 Zillow 強大得多,一定能預測市場!」

CFO 會提醒他,Zillow 的失敗不是模型不準,而是它運行的世界是象牙塔裡的幻想。他會問:「我們的模型能算出供應鏈中斷和裝修工人短缺的成本嗎?能預測到『檸檬市場』裡,賣家會利用我們漏洞的人性嗎?」

Zillow 的 8.8 億美元教訓:它的演算法精準地執行了一個基於錯誤假設的自殺任務,在 2021 年第三季度單季就虧損了驚人的 4.2 億美元。失敗原因包括:

演算法盲點:模型依賴房價上漲期的歷史數據,無法應對市場降溫。

忽略「檸檬市場」:AI 無法理解賣家會利用其估價漏洞的策略行為(逆向選擇)。

營運脫節:AI 的高效決策遭遇了供應鏈中斷和勞動力短缺的現實瓶頸。

CFO 的底線:你的模型再精確,如果它運行的世界是你想出來的,那它只會帶你高效地走向懸崖。AI 專案的風險,往往不在模型內,而在模型外的現實世界。

AI 專案救援手冊:CEO 與 CFO 的共同作戰指南

如何讓 CEO 的願景不變成 CFO 的噩夢?答案是建立一個雙方都認可的治理框架,一個共同的作戰手冊。

第一步:選擇正確的戰場(達成戰略共識)

用這四個原則,確保 CEO 和 CFO 在「打哪一仗」上達成一致:

人機協作模式:我們的 AI 是在「指導」專家,還是「輔助」專家?

找出真實痛點:我們是透過深度用戶研究發現的問題,還是坐在會議室裡想像出來的?

能力與需求匹配:我們有足夠且優質的數據嗎?用戶能容忍多大的錯誤率?犯錯的代價是什麼?

建立清晰價值:用具體數字回答:AI 能為用戶節省多少時間、降低多少成本、或提高多少準確率?

第二步:用故事板戳破幻想(將願景轉化為可審計的流程)

在寫任何程式碼之前,用最簡單的火柴人故事板,讓 CEO 向 CFO 證明「價值如何實現」。

如果你的故事劇本是「AI 心理治療師」一樣,聲稱能治癒重度憂鬱症,那麼其間的邏輯跳躍和風險會立刻暴露。

但如果你的故事劇本「社交焦慮助手」,清晰地展示瞭如何一步步提供價值,它才能獲得信任。

故事板是戳破幻想、將願景落地的最強工具。如果這個故事講不通,專案就該重新考慮。

(文章看到最後有彩蛋:精準灌溉系統、AI 心理治療師、社交焦慮助手的由來)

第三步:AI 專案紅綠燈檢查表(雙方都同意的動工前安檢)

如果專案通過了前兩關,用這個檢查表做最後的審查:

🔴 紅燈問題(立即停止,重新思考)

協作模式:這個專案的核心目標是取代某個團隊,還是增強他們的能力?

數據來源:我們的訓練數據,有沒有包含市場的劇烈波動?(Zillow 測試)是否可能延續歷史偏見?(SafeRent 測試)

人類否決權:如果 AI 給出災難性建議,流程中是否有人類專家擁有一票否決權?

文化問題:我們是否對監管或公眾抱持敵意?(Cruise 測試)

🟡 黃燈問題(保持警惕,深入討論)

KPI 校準:我們的 KPI 是獎勵「模型準確率」還是「業務成果」?

行銷邊界:我們是否過度行銷了這個 AI 的真實能力?(Tesla 測試)

營運現實:AI 的決策速度,是否超出了我們下游營運的承載能力?

錯誤預算:AI 犯錯的成本由誰承擔?我們有預算為它的錯誤、甚至它引發的訴訟買單嗎?

結語:從 CEO vs. CFO 到 CEO + CFO

所以,AI 轉型的成功,既不取決於 CEO 的決心,也不取決於 CFO 的謹慎。

它取決於這家公司是否建立了一個能讓他們進行高質量爭辯的流程。

因為在 AI 時代,最頂尖的公司,不是擁有最聰明 CEO 或最保守 CFO 的公司,而是他們的 CEO 和 CFO 能夠坐下來,用同一套救援手冊,就風險和回報達成共識的公司。

你的 AI 策略不是一份簡報,而是你的 CEO 和 CFO 對話的質量。

而那個終極問題,也不再是:「我們準備好為它的愚蠢買單了嗎?」

而是:

「我們的組織,準備好進行一場誠實且高效的對話了嗎?」

參與本次讀者調查活動,就有機會獲得三個月免費訂閱的權益,名額限定 10 名。

copyright © PrivacyUX consulting ltd. All right reserved.

關於本刊作者

Gainshin Hsiao 是 Agentic UX(代理式使用者體驗)的先驅,在人工智能與使用者體驗設計領域擁有超過 15 年的開創性實踐。他率先提出將用戶隱私保護視為 AI 產品設計的核心理念,於 2022 年創立 Privacyux Consulting Ltd. 並擔任首席顧問,積極推動隱私導向的醫療 AI 產品革新。此前,他亦擔任社交 AI 首席策略官(2022-2024),專注於設計注重隱私的情感識別系統及用戶數據自主權管理機制。