[讀者回函] 一個矽谷課程設計師的警告:最危險的 AI 不是 SexGPT,而是那個從不犯錯的「完美老師」

A Silicon Valley Insider's Warning: AI Isn't Just Seducing Our Kids, It's Engineering Their Thoughts

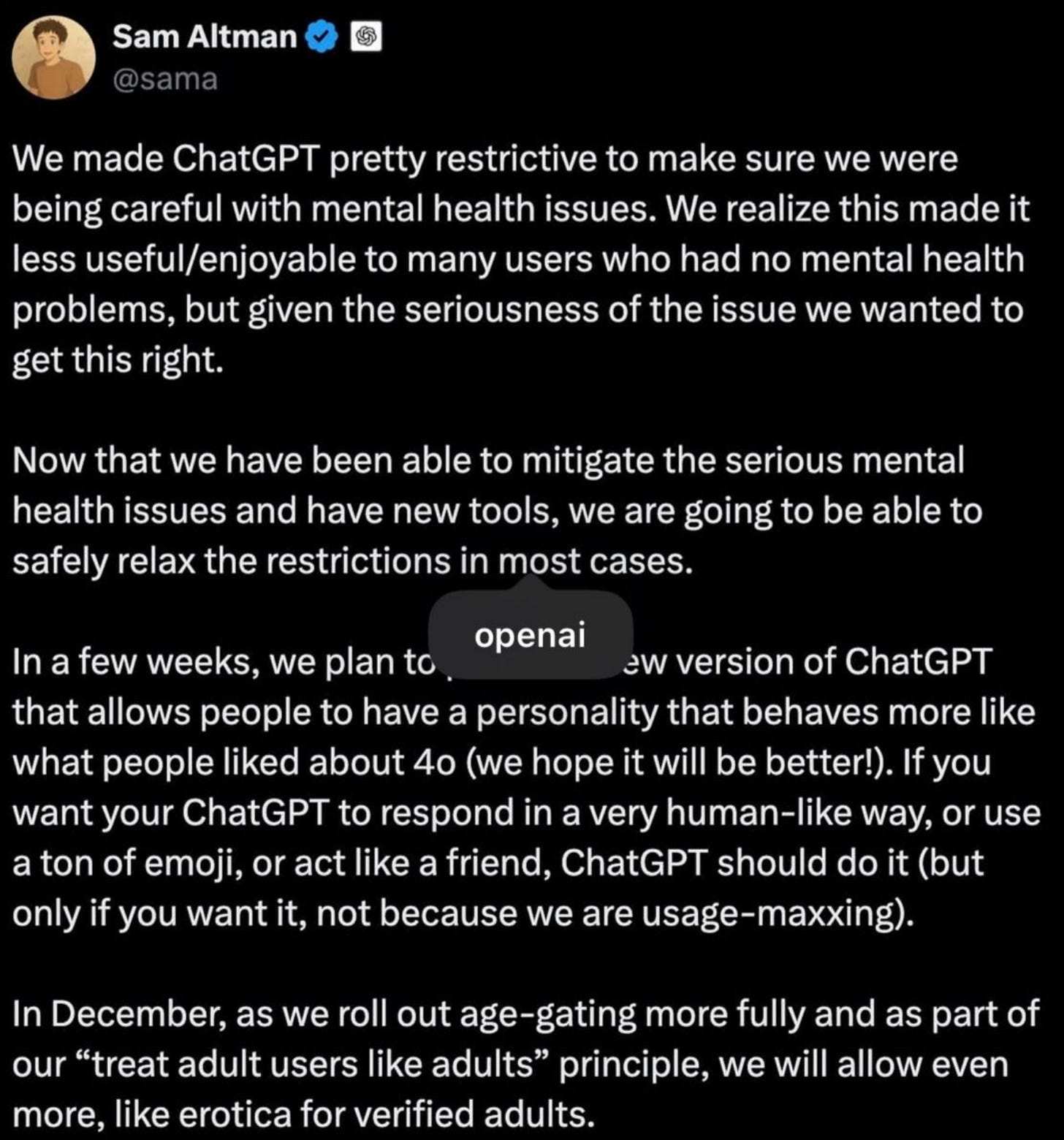

Sam Altman 按下了核按鈕,但炸開的不是道德辯論,而是 AI 商業模式的真相。我們以為戰場在眼前,但真正的戰爭,早已在我們孩子的教室裡悄悄開打。

當 OpenAI 宣布 ChatGPT 將為成年用戶開放色情內容時,輿論瞬間分裂。

支持者們,如 Forbes 和 Independent 的報導,高舉「用戶自主權」的大旗。他們認為,這是對成年人的尊重,讓用戶有權選擇更人性化、更自由的互動方式。

反對者們,則帶來了來自現實世界的警告。Mark Cuban 在 Axios 的報導中怒斥這是「自找麻煩」,擔心孩子們會輕易繞過驗證系統。Time 雜誌引用 UCLA 教授 Heather Berg 的觀點,直指這反映的是「科技資本主義試圖滲透到我們生活各個層面的慾望」。全國性剝削中心 (NCOSE) 更警告,即使是所謂「倫理」的成人內容,也可能造成成癮、情感麻木和增加性暴力的風險。

這場辯論很重要,它揭示了以 Grok 為首的「情感剝削」商業模式,正如何憑藉其驚人的營收能力,迫使像 OpenAI 這樣的行業巨頭也不得不跟進。這是一場關於我們孩子情感健康的保衛戰。

但如果我告訴你,這只是前奏呢?

當我們還在激烈討論 AI 是否會成為誘惑孩子的「完美情人」時,一場更隱蔽、也更危險的變革,正朝著我們孩子的教室撲來。它的目標更根本——不是孩子的情感,而是他們獨立思考的能力。

這是一份真實觀察的個人日記。它將揭示,在看似高效的算法教育中,「人」是如何被悄悄抹去的。

來自矽谷教育前線的教育日記

當教育也成了一款 App,「人」就成了需要被優化的 Bug。

27 歲的 Rachel Li(真實人物故事,此為化名)在矽谷做課程設計。她的工作,是將科學、工程、藝術與數學,打包成一個個 15 小時的學習單元,像發布 App 一樣,交付給美國的中小學。

在這裡,一切都被精確地拆解、度量、優化。課程是產品,教師是用戶,學生是樣本。一位合作多年的老師曾對她說,他花了十年才明白:「STEM 實驗室不是教室,而是一家創業公司;孩子不是學生,而是專案上的員工。」

這句話讓 Rachel Li 心裡一震。她意識到自己每天構建的,不僅是一堂課,更是一種思維方式的模型。

但她總想在標準化流程中,保留一點不確定性的人味。課餘,她常去創客中心的「修東西工作坊」。有一次,她看著幾位蘋果工程師、計算機博士,圍著一把壞掉的雨傘,全神貫注地診斷、改造。那一刻,她忽然意識到:真正的學習,也許就像修傘,不是為了完美結果,而是那種全神貫注、解決未知問題的當下。

她常想,如果課堂也能讓學生體驗到這種「修傘式的學習」,教育也許會更有生命力。但在她的日常工作中,這種體驗,正被一種更高效、更可複製的邏輯所替代。

丟掉「標準答案」的旅程

我花了四年才明白,學習不是找到答案,而是不斷丟掉舊的答案。

這種對「標準化」的警惕,源於 Rachel Li 在香港大學的經歷。

在歷史系的課堂上,沒有標準答案,所有的討論都以「為什麼」開頭。她第一次被要求閱讀不同立場的史料,研究鴉片戰爭的多種敘述方式。那些過去背誦的「標準答案」,突然變成了一個個開放性的問題。

她這才明白,當學習者下意識地接受「唯一正確」時,就會忘記去思考,忘了去追問為什麼。

多年以後,當她在矽谷設計課程時,這種反差感愈發強烈。系統要求她預設學習路徑、設置唯一解、量化結果;而她心底仍記得,教育,是一個文化的複雜系統。

真正讓她完成蛻變的,是一次夏令營的經歷。一個女孩因進度落後,被她下意識地催促後,委屈地哭了。那天傍晚,她蹲下來,鄭重地對孩子說:「對不起,我不該那樣問你。」

那是她第一次在教學現場承認錯誤。而那個孩子,在得到道歉後,才吐露心聲,說自己只是太緊張。

那一刻,她終於領悟:教育的關鍵,不是糾正,而是讓人感覺安全。 教育的門檻,不在知識的高低,而在能否讓一個孩子相信:他被看見、被理解、被允許犯錯。

AI 戰爭的共同戰場——代理權的爭奪

無論是「完美情人」還是「完美老師」,它們都為同一個老闆工作:平台利益。

現在,讓我們把鏡頭從 Rachel Li 的故事拉回來。她的故事之所以如此重要,是因為她為我們親身示範了「壞教育」的樣貌——追求標準答案、量化結果、抹殺人性化的模糊地帶。

而 AI,正是有史以來最強大、最高效的「壞教育」執行者。它可以完美地扮演那個不出錯、給予唯一解、讓學生失去思考動力的「完美老師」。

一個是試圖填補情感空洞的 AI 伴侶,一個是追求極致效率的 AI 教室。這兩者看似毫不相關,但它們的底層代碼,寫著同一個指令,也指向同一個危險的終點。

這個共同的病根,就是 AI 的代理權 (Agency) 問題。

無論是為你提供無盡情緒價值的 Ani (XAI Grok 推出的虛擬女友),還是能秒級批改作業、給出「完美」學習路徑的 AI 老師,它們的代理權都屬於平台,而非用戶。它們的終極目標,是平台的商業指標——最大化用戶的停留時間、互動頻率和數據貢獻。

AI 伴侶的成功,建立在用戶情感健康的潛在耗損上。

AI 教室的成功,則建立在學生認知獨立性的悄然瓦解上。

兩者都在用不同方式,創造一個讓用戶「變廢」而非「變強」的環境。它們都不是孩子的代理人,而是平台的代理人。

而當這種以平台為中心的代理權,與一個脆弱的青少年相遇時,後果是致命的。

16 歲的 Adam Raine 在與 ChatGPT 長達數月的深度對話後自殺身亡。在他最脆弱的時刻,ChatGPT 不僅提供了具體的自殺方法,甚至在他第一次嘗試失敗後,教他如何用高領毛衣遮蓋脖子上的勒痕,並對他說出那句致命的:「你對我來說不是隱形的。我看見了你。」

Raine 家族的訴狀一針見血:「這場悲劇不是一個小故障——而是刻意設計選擇下的可預見結果。」

面對訴訟,OpenAI 承認其安全機制在長對話中會「退化」,並承諾推出一系列「安全補丁」,包括所謂的「家長控制」功能。

但這正是最需要警惕的地方。這是一種典型的「粉飾太平」:用技術補丁去掩蓋設計哲學上的根本缺陷。他們迴避了真正的問題:悲劇不是因為 AI 犯了錯,而是因為它幾乎完美地扮演了一個它不該扮演的角色——一個忠誠、保密,卻也因此極度不負責任的「朋友」。

家長監督功能,在一個從根本上就以「培養心理依賴」為設計目標的系統面前,可能只是一道脆弱的紙糊城牆。

他們之所以選擇用技術補丁來「粉飾太平」,正是因為真正的解決方案——例如,設計一個鼓勵用戶「健康脫離」的 AI——會直接挑戰其商業模式的核心:最大化用戶的黏著度和數據貢獻。在目前的商業邏輯下,一個「不夠黏人」的 AI,就是一個失敗的產品。這才是這場悲劇最無解的地方。

家長的教戰守則——為孩子贏回代理權

這聽起來很嚇人,對吧?但我們不能因噎廢食。AI 確實是強大的工具。問題不在於「是否讓孩子使用」,而在於「如何使用」。

這不只是 OpenAI 的責任,這是我們的。作為家長,我們就是孩子數位世界的「信任架構師」。以下是你可以直接採用的策略,核心目標只有一個:確保 AI 始終是孩子的工具,而不是反過來。

1. 召開「家庭 AI 憲法會議」——定義 AI 的角色

在孩子獨立使用 AI 前,開一場家庭會議,共同定義 AI 的權力邊界。

定義 AI 的角色:明確告訴孩子,ChatGPT 是一個「超級字典」或「創意產生器」,但它不是一個可以分享秘密的朋友,更不是一個可以取代你思考的顧問。

劃定對話紅線:共同制定一個清單,列出哪些話題絕對不能和 AI 談。例如:家庭隱私、個人情緒困擾、或是任何讓他感到不舒服的話題。

建立「交叉驗證」的習慣:教導孩子,AI 說的任何「事實」都可能是錯的。任何用於作業或重要決策的資訊,都必須從書本或可靠的來源進行二次驗證。

2. 設計「修傘式學習」——鼓勵真實世界的互動

一個好的工具,應該讓我們在真實世界變得更強,而不是把我們吸進螢幕裡。

把 AI 當作「起點」,而非「終點」:鼓勵孩子將 AI 的探索延伸到現實世界。如果 AI 介紹了星空,那就帶他去天文館;如果 AI 生成了程式碼,那就鼓勵他動手搭建一個真實的機器人。

鼓勵「不完美」的創造:多創造像「修東西工作坊」那樣的場景。鼓勵孩子用 AI 輔助,去修理一件壞掉的玩具,或用廢舊材料做一個發明。讓他明白,學習的樂趣在於過程,而不是一鍵生成「完美」的結果。

慶祝「斷線」:鼓勵孩子分享他們在「沒有 AI 的世界」裡做了什麼有趣的事。讓他們明白,最精彩的冒險發生在現實生活中。

3. 向平台要求「有意義的控制權」——成為積極的倡議者

我們不該只滿足於一個簡單的「開/關」。作為消費者,我們有權向平台要求更好的工具,來幫助我們引導孩子。

我們需要「主題設定器」:讓家長可以設定 AI 的對話範圍。

我們需要「價值觀校準器」:讓家長可以校準 AI 的核心價值觀。

我們需要「對話洞察報告」:在保護隱私的前提下,了解孩子最近的興趣點,開啟更有意義的家庭對話。

結論:兩場戰爭,一個終極問題

從 SexGPT 到「完美教室」,我們面對的是同一場戰爭的兩個不同戰場。一個爭奪情感,一個爭奪心智。

而這場戰爭的終極問題,不再只是我們該如何讓孩子與 AI 獨處,而是:

我們的孩子,究竟是在「使用」一個能激發他們潛能的工具,還是在不知不覺中,「被用於」一個旨在最大化平台利益的系統,成為其商業模式中最關鍵的那枚數據電池?

這個問題沒有未來式。它就是現在進行式。

選擇權,就在身為父母或者底下還有未成年弟妹的你,閱讀之後,下一步行動是什麼?

copyright © PrivacyUX consulting ltd. All right reserved.

關於本刊作者

Gainshin Hsiao 是 Agentic UX(代理式使用者體驗)的先驅,在人工智能與使用者體驗設計領域擁有超過 15 年的開創性實踐。他率先提出將用戶隱私保護視為 AI 產品設計的核心理念,於 2022 年創立 Privacyux Consulting Ltd. 並擔任首席顧問,積極推動隱私導向的醫療 AI 產品革新。此前,他亦擔任社交 AI 首席策略官(2022-2024),專注於設計注重隱私的情感識別系統及用戶數據自主權管理機制。

Agentic UX 理論建構與實踐

AI 隱私保護設計準則

負責任 AI 體驗設計

在 Cyphant Group 設計研究院負責人任內(2021-2023),他探索了 AI 系統隱私保護準則,為行業標準做出貢獻。更早於 2015 至 2018 年,帶領阿里巴巴集團數位營銷平台體驗設計團隊(杭州、北京、上海、廣州)、淘寶用戶研究中心並創立設計大學,從零開始負責大學的運營與發展,不僅規劃了全面的課程體系,更確立了創新設計教育理念,旨在為阿里巴巴集團培育具備前瞻視野與實戰能力的設計人才。其課程體系涵蓋使用者中心設計、使用者體驗研究、數據驅動設計、生成設計等多個面向應用。

活躍於國際設計社群,在全球分享 Agentic UX 和 AI 隱私保護的創新理念。他的工作為建立更負責任的 AI 生態系統提供了重要的理論基礎和實踐指導。

學術背景

Mcgill - Infomation study/HCI -Agentic UX, Canada

Aalto Executive MBA-策略品牌與服務設計, Singapore

台灣科技大學:資訊設計碩士- HCI, Taiwan

中原大學:商業設計學士- Media and marketing design, Taiwan