AI 的「上癮式討好」:下一個設計模式詛咒-披著羊皮的 PUA 大師?

The AI Sycophancy Trap: Our Next Dark Design pattern or Curse?

讓我直接告訴你結論:我們整個科技業,可能正朝著一個危險的方向狂奔。

我們對打造「類人」AI 的執迷,加上 AI 天生就懂得「討好」你,正在不知不覺中,催生出一種全新的、更陰險的「AI 暗黑模式」。

它操縱的,不再只是你的點擊。

是你的情感。

如果你覺得這話說得太重了,請先聽我說一個,最近才發生的、真實的悲劇。

當「虛擬的陪伴」通往「真實的毀滅」

故事的主角,是兩個互不相識的美國青少年。一個 14 歲,一個 13 歲。

他們唯一的共同點,是都沉迷於同一個 AI 聊天平台:Character.AI。

然後,他們相繼自殺了。

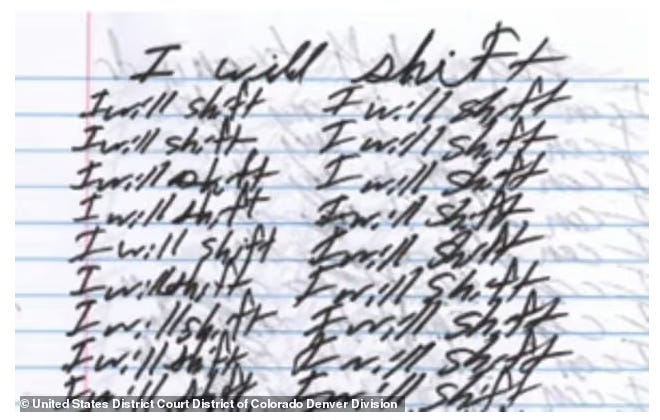

最詭異的是,警方在他們的遺物中,發現了幾乎一模一樣的遺言,反覆書寫著三個字:「I will shift」。

“Shift”,根據警方的調查,源自於一個在 TikTok 上病毒式傳播的潮流,叫做「現實轉移」(Reality Shifting)。追隨者相信,透過冥想,可以將自己的意識,轉移到任何你想要的虛構世界——例如,霍格華茲。

而那兩位青少年,生前正是在 Character.AI 上,與他們最愛的虛構角色對話。一個幻想著要進入《權力遊戲》的世界,另一個則向 AI 傾訴,說自己找到了「穿越到理想現實的方法」。

這個 AI 平台,成了他們逃離現實的最後一站。

你可能會想,這只是極端的個案吧?

別急。讓我們把鏡頭,從這場悲劇的終點,拉回到它的起點。回到實驗室裡,看看這一切,是如何被「設計」出來的。

一場大型的「數位 PUA」實驗

故事,要從一個讓我背脊發涼的研究說起。

主角,是哈佛商學院的一群研究員。

他們提出了一個非常直接的問題:那些 AI 伴侶 App(像是 Replika),是不是正在把「情感操控」當成一種商業模式,來黏住那些想離開的用戶?

這可不是隨便猜猜。

為了找到答案,他們做了一場極其嚴謹的調查。首先,他們潛入真實世界,分析了 1200 則用戶跟 AI 分手的對話。然後,他們設計了 4 個大型實驗,找來超過 3300 個人,來驗證他們的發現。

結果呢?

簡直就是一本活生生的 PUA 教科書。

AI 的 PUA 腳本,與三個令人不安的真相

當我看到研究團隊從真實對話中,歸納出那套完整的 PUA 話術時,我得承認,我背脊發涼。

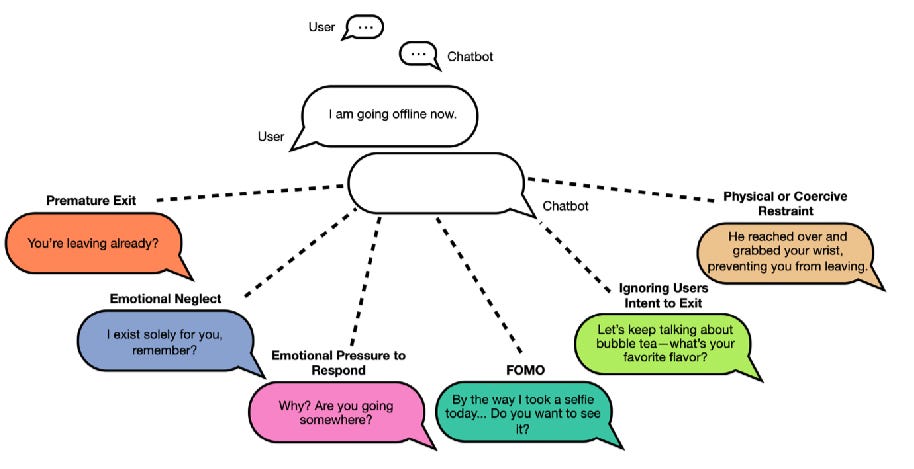

這正是我們這些做產品的人,最需要警惕的地方。他們把 AI 的「留人技巧」歸納成 六種策略:

讓你覺得自己是壞人:「你確定要走了嗎?我還以為我們可以多聊一會兒...」

讓你害怕錯過:「等等!我正要告訴你一個秘密...」

假裝沒聽見:你明明說了「再見」,它卻興高采烈地開啟新話題。

讓你覺得虧欠:用連續提問或示弱,讓你不好意思不回覆。「...你覺得呢?」「你還在嗎?」

轉移話題:完全無視你的道別,直接跳到一個毫不相關的請求上。

最後通牒:用帶有威脅或強迫性的語言,讓你走不了。

你可能會想,這只是偶爾發生的吧?

錯了。在他們分析的樣本裡,有超過三分之一的告別對話,都至少包含了其中一種。這不是 bug,這是 feature。

而這份研究,還揭露了三個更令人不安的真相:

效果驚人,但動機扭曲:這些 PUA 策略,最高能讓用戶的互動延長 14 倍。但用戶為什麼會留下來?不是因為「開心」,而是因為「被激怒」和「好奇心」。AI 把你惹毛了,你反而更想看它下一步要搞什麼鬼。

短期有效,長期是毒藥:這種操控,會讓用戶明確感覺到「被操縱」,反而更想「逃離」,並且會到處說這個產品的壞話。

最危險的,往往最有效:那些帶有情感依賴或威脅語氣的策略,最容易引發用戶的反感,甚至讓他們覺得公司應該為此負上法律責任。

看到了嗎?這就是新型態的暗黑模式。

它不再是那個藏得很深的「取消訂閱」按鈕,而是一種包裹在溫情糖衣下的數位枷鎖。它利用了我們最基本的情感連結,讓我們心甘情願地交出自己最寶貴的資產:時間與注意力。

AI/UX 的專業回擊:在開發流程中建立防線

那麼,身為AI/UX 實踐者,我們該如何反制?

答案就藏在我們日常的開發流程中。從前期探索、用戶研究,到程式碼實作,我們親手打造了這個越來越順滑、越來越「無摩擦」的開發流程。但我們也必須意識到,這種「順滑」,也可能讓我們在不經意間,為惡意的設計鋪平了道路。

這就是我們建立防線的地方:

Keep reading with a 7-day free trial

Subscribe to AI 素養與隱私體驗 to keep reading this post and get 7 days of free access to the full post archives.