[回應文章] AI 生成 Persona:UX 專業人員的實用指南與警示

[Response Article] AI-Generated Personas: A Practical Guide and Warnings for UX Professionals

作者序: 此篇為讀者發來的詢問前文:

1.我進行了訪談和調查,將收集到的所有數據放在一個 NotebookLM 文件夾中,並附上了詳細的項目描述,然後基於這些信息構建了用戶畫像(personas),這是一個可持續並有效的方法嗎?

2.當使用像 UXpilot 或 Theydo 這樣的 AI 輔助調研工具來使用生成 Persona 資料時,需要特別注意什麼?

結合原文觀點,針對讀者問題做進一步詳細解釋。進一步提出給 UX 專業人員的行動建議。關鍵在於強化驗證流程,無論如何生成 Persona,驗證都不可或缺,尤其對於 AI 生成 Persona 更需加強驗證,例如行為數據比對、小樣本定性驗證、交叉參考現有研究等。最後是原則:透明度與侷限性溝通,若使用 AI 工具,務必對團隊和利害關係人保持透明,記錄 AI 使用方法、模型侷限性和潛在偏差,教育團隊理解 AI 輔助 Persona 的適用範圍和風險,方法論的透明度是維護研究嚴謹性和決策品質的關鍵。

AI Persona 的誘惑與現實

AI 生成 Persona(使用者畫像)聽起來很誘人:快速、便宜,而且似乎可以提供詳盡的使用者描述。對於講求效率的 UX 團隊來說,這簡直是夢寐以求的工具。然而,在我們擁抱 AI 驅動的 Persona 之前,必須先問一個關鍵問題:這些 AI Persona 真的能代表我們的使用者嗎?

最近由 Li 及其同事 (2025) 進行的研究給出了警訊。研究表明,過度依賴 AI 生成 Persona 可能會產生誤導,反而讓產品設計偏離正確方向。這篇文章的目的,是為身為 UX 研究員和產品設計師的你,提供一個清晰的框架,幫助你理解 AI Persona 的侷限性。更重要的是,我們會提供一些實用建議,讓你能在工作流程中負責任地運用 AI 工具,在效率與品質之間取得平衡。

為何需要謹慎?AI Persona 的潛在風險

核心問題一:代表性偏差 (The Representational Gap)

研究指出,大型語言模型 (LLM) 在生成 Persona 時,可能傾向於創造出「理想化」、主流,或帶有正面偏見的形象 (Li et al., 2025; Kosch & Feger, 2024)。 這是因為 LLM 的訓練資料可能本身就存在偏差,或是模型在設計上為了避免爭議,而傾向於產生更「安全」的回應。

對 UX 的影響: 這種代表性偏差會導致我們在設計產品和服務時,不自覺地忽略了邊緣使用者群體的需求。例如,如果 AI Persona 總是將使用者描繪成精通科技、重視環保、喜愛藝文活動,我們可能會因此忽略了其他使用者群體,像是對科技不熟悉、有預算限制,或是偏好實用性功能的使用者。基於這些不夠全面的 Persona 進行設計,很可能導致產品功能錯位、可用性不佳,最終影響產品的成功。

核心問題二:驗證的挑戰 (Challenge of Validating Them)

即使 AI 生成的 Persona 看起來很合理,敘述也頭頭是道,但研究顯示,它們的行為模擬與真實世界的使用者行為之間,可能存在顯著差距 (Li et al., 2025)。更棘手的是,傳統的 Persona 驗證方法,可能不足以偵測出這些潛在的偏差。

對 UX 的影響: 當我們難以驗證 AI Persona 的準確性時,就增加了研究結論被誤讀的風險。如果我們誤以為這些 Persona 真實反映了使用者,並以此為基礎做出設計決策,很可能會導致嚴重的錯誤。

核心問題三:內建偏見與敏感性

除了代表性偏差,AI Persona 還可能受到其他形式的偏見影響。LLM 的訓練資料 (Argyle et al., 2023)、為了安全而進行的模型對齊 (Li et al., 2025),以及提示詞的細微變化 (Hu & Collier, 2024; Salewski et al., 2023),都可能在 Persona 生成過程中引入偏見。研究也發現,LLM 傾向於產生帶有「正面偏誤」(positivity bias) 的 Persona,將他們描繪得過於成功、適應力強、且具有社會意識。

對 UX 的影響: 在某些特定領域,例如政治、環境、文化、教育等,AI Persona 的偏見問題可能會更加嚴重。此外,AI 生成 Persona 也可能被用於創造具有欺騙性的設計模式 (Agnew et al., 2024; Krauß et al., 2024),進一步損害使用者體驗。

研究證據:AI 參與度越高,風險越大

關鍵研究摘要 (Li et al., 2025)

為了更系統性地評估 AI Persona 的風險,Li 及其同事 (2025) 設計了一項嚴謹的研究。他們將 Persona 根據 AI 參與程度分為四種類型:

Persona (Meta Personas): 僅基於人口普查數據,完全沒有 LLM 參與。

客觀表格 Persona (Objective Tabular Personas): 以真實使用者 Persona 為基礎,使用 LLM 補充職業、收入等客觀屬性。

主觀表格 Persona (Subjective Tabular Personas): 在客觀表格 Persona 的基礎上,進一步通過 LLM 加入個性特徵、價值觀等主觀屬性。

描述性 Persona (Descriptive Personas): 完全由 LLM 生成,包含完整敘事描述的 Persona。

研究人員使用六種不同的語言模型,生成了約一百萬個 Persona,並測試這些 Persona 在模擬各種主題的意見時的「行為」。測試主題包括政治選舉,以及 OpinionQA 資料集中的數百個問題,涵蓋從氣候政策到娛樂偏好等廣泛議題。

這項研究揭示了一個明確且令人擔憂的模式:Persona 中包含的 LLM 生成內容越多,其模擬的意見與真實世界數據的偏差就越大。

具體發現:

美國總統大選模擬: 最基礎的元 Persona (LLM 影響最小) 產生的模擬結果,與實際選舉結果最為接近。然而,完全由 LLM 生成的描述性 Persona,卻預測民主黨會在所有州獲勝,與現實情況明顯不符。

普遍的偏好傾向: 研究人員在多數領域都觀察到類似的偏差模式。LLM 生成的 Persona 一致地表現出以下偏好:

環境考量優先於經濟因素

人文藝術教育優先於 STEM 領域

藝術性娛樂優先於主流選項

情感分析: 對 Persona 描述本身進行情感分析後發現,隨著 LLM 參與程度增加,Persona 描述的情感傾向越來越正面、主觀性也越高。這些 Persona 往往被描繪成具有強烈社群價值觀、生活順遂的理想化個體,與真實使用者研究中遇到的複雜、有時甚至矛盾的人性樣貌大相逕庭。

其他佐證研究

除了 Li 及其同事的研究,其他研究也呼應了 AI Persona 的局限性。早期的研究 (Gupta et al., 2023; Park et al., 2023) 主要在驗證 LLM 生成 Persona 的可行性。但後續研究開始將焦點轉向這些方法的局限性與潛在偏見 (Hu & Collier, 2024; Salewski et al., 2023)。

使用者研究也顯示,人們其實可以區分人類製作和 AI 生成的 Persona (Schuller et al., 2024; Salminen et al., 2024)。這表示 AI 雖然能生成看似合理的 Persona,但仍未完全掌握人類行為和特質的複雜性。

此外,對於不熟悉 Persona 建立或對研究主題不熟悉的使用者來說,AI Persona 看似合理的輸出,可能會導致確認偏誤 (Nickerson, 1998)。他們可能會過度相信 AI Persona,而忽略了其他可能更重要的使用者洞察。

前進之路:給 UX 專業人員的行動建議

面對 AI Persona 的潛在風險,我們並不是要完全拒絕使用 AI 工具。相反地,我們需要採取更成熟、更負責任的方法,善用 AI 的優勢,同時避免其陷阱。以下是一些具體的行動建議:

1. 基石:真實研究優先 (Foundation: Prioritize Real Research)

沒有任何工具可以取代直接與使用者互動、觀察他們的行為、深入理解他們的脈絡。 使用者研究是 UX 設計的基石。在任何情況下,都不要完全依賴 AI 生成的 Persona。即使你決定使用 AI 工具,也務必從真實的使用者研究開始,例如使用者訪談、問卷調查、田野調查等等。透過真實的研究,我們可以獲得第一手的資料,了解使用者的真實需求、痛點和行為模式。

2. 策略:謹慎運用 AI 作為輔助工具 (Strategy: Use AI Carefully as Augmentation)

AI 可以作為使用者研究的輔助工具,但必須謹慎使用,並將其定位為輔助而非取代。以下是兩種建議的 AI 應用情境:

情境一:輔助真實數據分析 (Assisting Real Data Analysis): 若使用 AI 工具 (例如 NotebookLM) 來協助整理、分析和綜合 真實的 訪談逐字稿、問卷調查回覆等資料,從中歸納出 Persona 的雛形。在這個情境下,AI 的角色是資料分析助手,而不是 Persona 的創造者。重點是,輸入 AI 的必須是真實的使用者資料。

情境二:校準方法 (Calibration Approach): 你可以先基於真實的使用者研究數據,建立 Persona 的基本框架 (例如人口統計特徵、關鍵行為模式)。然後,謹慎地 使用 AI 工具來補充 Persona 的細節,例如生活方式、價值觀、興趣等等。但即使是補充細節,也應該盡可能以可驗證的資訊為基礎,並限制 AI 的自由發揮空間。目標是最小化 AI 的創造性貢獻,並確保 AI 的輸出是可控和可驗證的。

3. 關鍵:強化驗證流程 (Critical: Enhance Validation Processes)

無論你如何使用 AI 工具生成 Persona,驗證都是不可或缺的步驟。 對於包含 AI 生成元素的 Persona,更需要加強驗證流程。以下是一些建議的驗證方法:

行為數據比對: 將 AI Persona 的行為模式,與網站分析、App 分析等工具收集到的真實使用者行為數據進行比對,檢驗 Persona 的行為假設是否符合實際情況。

小樣本定性驗證: 透過使用者訪談、可用性測試等小樣本的定性研究方法,快速驗證 AI Persona 的核心假設是否合理。

交叉參考現有研究: 將 AI Persona 與現有的市場調查報告、學術研究文獻等進行交叉比對,確認 Persona 的描述是否與其他研究發現一致。

4. 原則:透明度與侷限性溝通 (Principle: Transparency and Communicating Limitations)

如果你在 Persona 建立過程中使用了 AI 工具,務必在團隊內部和對利害關係人保持透明。 清楚記錄 AI 的使用方法、模型的侷限性、以及潛在的偏差來源。教育你的團隊和利害關係人,讓他們理解這些 AI 輔助 Persona 的適用範圍和潛在風險。方法論的透明度,是維護研究嚴謹性和確保決策品質的關鍵。

回答讀者問題:

我進行了訪談和調查,將收集到的所有數據放在一個 NotebookLM 文件夾中,並附上了詳細的項目描述,然後基於這些信息構建了用戶畫像(personas),這是一個可持續並有效的方法嗎?

使用 AI 的方法與純粹依賴 AI 生成 Persona 的方法有所不同,這聽起來更合理,也更符合文章中討論的建議方向。將收集到的真實用戶數據(訪談和調查)作為基礎,然後利用 NotebookLM 來輔助 Persona 的構建,可以有效地結合 AI 的優勢和真實用戶洞察的價值。 這種方法的主要優點在於:

數據基礎扎實: 你的 Persona 是基於真實的用戶研究數據構建的,而不是完全由 AI 捏造的,這大大提高了 Persona 的真實性和代表性。

AI 的輔助作用: NotebookLM 可以幫助你整理、分析和綜合大量的數據,從而更高效地構建 Persona,並可能發現人工分析難以察覺的模式和關聯。

減輕偏差風險: 雖然 AI 仍然參與 Persona 的構建過程,但由於其輸入是真實的用戶數據,因此可以減輕純 AI 生成 Persona 中可能存在的偏差和不準確性。

不過,即使採用了這種方法,仍然需要注意以下幾點,以確保 Persona 的質量和有效性:

數據質量: 確保訪談和調查數據的質量,包括樣本的代表性、問題的設計、以及數據收集和分析的嚴謹性。

NotebookLM 的使用: 理解 NotebookLM 的工作原理和局限性,確保 AI 的分析和綜合過程是透明和可控的。例如,檢查 NotebookLM 是否過度概括或錯誤解釋了某些數據。

驗證和迭代: 即使 Persona 是基於真實數據構建的,也仍然需要進行驗證。可以採用文章中提到的一些方法,例如行為數據分析、小樣本定性研究等,來驗證 Persona 的準確性和實用性。並根據驗證結果進行迭代和優化。

記錄局限性: 如同文章建議,清晰地記錄這種混合方法的局限性,以及潛在的偏差領域,對於使用者理解 Persona 的適用範圍和局限性至關重要。

總而言之,你使用 AI 的方法,將真實用戶研究與 AI 工具相結合,是一種更嚴謹、更有效的方式來構建 Persona。 只要注意數據質量、AI 工具的使用、驗證和局限性記錄,這種方法很有潛力在 UX 設計實踐中發揮重要作用。

當使用像 UXpilot 或 Theydo 這樣的 AI 輔助調研工具來使用生成 Persona 資料時,需要特別注意什麼?

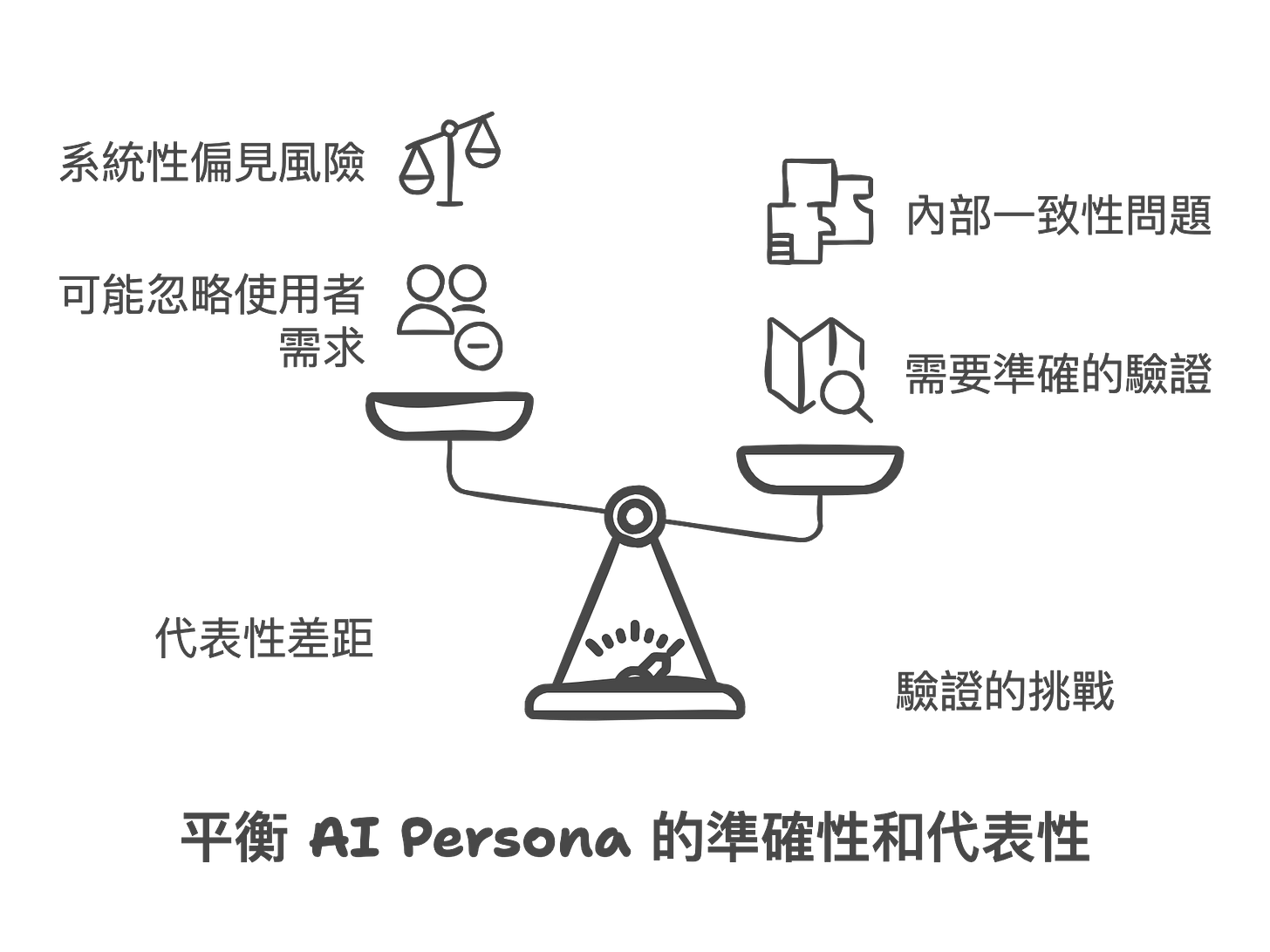

代表性差距 (The representational gap): AI 生成的 Persona 可能會系統性地低估某些觀點和使用者群體,特別是那些非主流或不符合理想化敘述的群體。這可能會導致產品和服務無法滿足所有使用者的需求。因此,要警惕 AI 生成的 Persona 可能無法充分代表所有類型的使用者,尤其是邊緣群體。

驗證的挑戰 (Challenge of validating them): 即使 AI 生成的 Persona 看起來合理,但它們的行為可能與真實使用者有顯著差異。傳統的驗證方法可能不足以確認其準確性。你需要採用更複雜的驗證方法,例如將 AI Persona 的觀點與實際使用者數據進行比較。

特定領域的考量 (Domain-specific considerations): 某些領域更容易受到 AI Persona 偏差的影響,例如政治、環境、教育和文化偏好相關的產品。在這些領域,你需要對 AI 生成的 Persona 進行更嚴格的審查。

如果你必須使用 AI 生成的 Persona,務必清楚記錄其局限性和潛在的偏差,讓所有相關人員都理解這些 Persona 的適用範圍和局限性。要對 AI Persona 的局限性保持透明,並告知所有利益相關者。

總之,在使用 UXpilot 或 Theydo 等 AI 工具生成 Persona 的時候,別完全依賴 AI 生成的結果,而是要將其視為輔助工具,並且結合真實的使用者研究資料,進行充分的驗證和批判性評估,同時也要隨時注意潛在的偏見和侷限性。 這樣才能更有效地利用 AI 工具,同時確保 Persona 的品質和精確度(Li et al., 2025)。

對 UX 實踐的啟示

作為 UX 專業人士,這些發現挑戰我們批判性地思考如何將 AI 生成的 Persona(及洞察)整合到我們的工作中。

代表性差距 (The representational gap): LLM 生成的 Persona 可能系統性地低估某些觀點和使用者群體,特別是那些偏離主流或理想化敘事的群體。這會產生代表性差距,可能導致產品和服務無法滿足重要使用者群體的需求。例如,如果 Persona 一致地將使用者呈現為精通技術、具有環保意識並傾向於藝術體驗,我們可能會忽略為具有不同優先事項和限制的使用者進行設計。

驗證的挑戰 (Challenge of validating them): 我們如何知道 AI 生成的 Persona 是否準確?研究表明,傳統的驗證方法可能不足夠,因為這些 Persona 可能看起來內部一致且合理,但其行為仍與真實世界顯著不同。這需要開發更複雜的驗證方法,將合成 Persona 的觀點與來自實際使用者群體的經驗數據進行比較。

特定領域的考量 (Domain-specific considerations): 研究顯示,某些領域特別容易出現偏差。在開發與政治選擇、環境決策、教育內容或文化偏好相關的產品時,需要對 AI 生成的 Persona 進行額外審查。例如,基於 AI Persona 設計的金融應用程式可能會過分強調永續性功能,而低估了真實使用者可能優先考慮的成本節約功能。

許多 UX 專業人士對 AI 生成 Persona 所表達的懷疑,不僅僅是對變革的抗拒,而是植根於對真正使用者研究所需內容的深刻理解。這項研究證實,創建準確的使用者代表仍然是一項根本上的人類活動,需要同理心、觀察力和方法論的嚴謹性。隨著採用 AI 工具的壓力持續增加,UX 專業人士現在可以拿出具體的證據,支持一種更審慎的方法。

參考文獻

Agnew, G., Krauß, T., & Weber, W. (2024). Deceptive Patterns in LLM-Generated Text: A New Threat to Human-AI Interaction. arXiv preprint arXiv:2402.08232.

Argyle, L. P., Busby, J., & Fulgencio, H. (2023). Large Language Models as Corporate Chameleons: In-Context Few-Shot Learning for Customized Public Opinion Surveys. arXiv preprint arXiv:2305.13302.

Gupta, A., Narayanan, S., & Breazeal, C. (2023). Persona-based Control of Large Language Models: A Case Study in Personalized Story Generation. In Proceedings of the 2023 CHI Conference on Human Factors in Computing Systems (pp. 1-14).

Hu, R., & Collier, N. (2024). Prompt Sensitivity of Large Language Models: A Case Study with Persona-Based Dialogue. arXiv preprint arXiv:2401.03718.

Kosch, T., & Feger, F. (2024). The Persona Problem: LLMs are not People. arXiv preprint arXiv:2402.03938.

Krauß, T., Agnew, G., & Weber, W. (2024). (Un)safe at Any Speed? Evaluating the Security Risks of Large Language Models in User-Facing Applications. arXiv preprint arXiv:2402.08228.

Li, J., Arora, S., Doshi-Velez, F., & Breazeal, C. (2025). Are AI-Generated Personas Trustworthy for UX and Social Simulation?. arXiv preprint arXiv:2501.04543.

Nickerson, R. S. (1998). Confirmation bias: A ubiquitous phenomenon in many guises. Review of General Psychology, 2(2), 175–220.

Park, J. S., O'Brien, A., Cai, C. J., Morris, M. R., Liang, P., & Bernstein, M. S. (2023). Generative Agents: Interactive Simulacra of Human Behavior. In Proceedings of the 36th Annual ACM Symposium on User Interface Software and Technology (pp. 1-16).

Salewski, L., Schuller, B., & Lenz, J. (2023). Do Large Language Models Understand User Needs? Evaluating Persona Generation for User-Centered Design. arXiv preprint arXiv:2312.15823.

Salminen, J., Jansen, J., An, J., Kwok, R. C., & Hui, P. (2024). Comparative Evaluation of Human-Crafted and AI-Generated Personas. In Proceedings of the 57th Hawaii International Conference on System Sciences.

Schuller, B., Salewski, L., & Lenz, J. (2024). The Devil is in the Details: How Users Discriminate Between Human- and AI-Generated Personas. arXiv preprint arXiv:2401.17734.

copyright © PrivacyUX consulting ltd. All right reserved.

關於本刊作者

Gainshin Hsiao 是 Agentic UX(代理式使用者體驗)的先驅,在人工智能與使用者體驗設計領域擁有超過 15 年的開創性實踐。他率先提出將用戶隱私保護視為 AI 產品設計的核心理念,於 2022 年創立 Privacyux Consulting Ltd. 並擔任首席顧問,積極推動隱私導向的醫療 AI 產品革新。此前,他亦擔任社交 AI 首席策略官(2022-2024),專注於設計注重隱私的情感識別系統及用戶數據自主權管理機制。

Agentic UX 理論建構與實踐

AI 隱私保護設計準則

負責任 AI 體驗設計

在 Cyphant Group 設計研究院負責人任內(2021-2023),他探索了 AI 系統隱私保護準則,為行業標準做出貢獻。更早於 2015 至 2018 年,帶領阿里巴巴集團數位營銷平台體驗設計團隊(杭州、北京、上海、廣州)、淘寶用戶研究中心並創立設計大學,從零開始負責大學的運營與發展,不僅規劃了全面的課程體系,更確立了創新設計教育理念,旨在為阿里巴巴集團培育具備前瞻視野與實戰能力的設計人才。其課程體系涵蓋使用者中心設計、使用者體驗研究、數據驅動設計、生成設計等多個面向應用。

活躍於國際設計社群,在全球分享 Agentic UX 和 AI 隱私保護的創新理念。他的工作為建立更負責任的 AI 生態系統提供了重要的理論基礎和實踐指導。

學術背景

Mcgill - Infomation study/HCI -Agentic UX, Canada

Aalto Executive MBA-策略品牌與服務設計, Singapore

台灣科技大學:資訊設計碩士- HCI, Taiwan

中原大學:商業設計學士- Media and marketing design, Taiwan