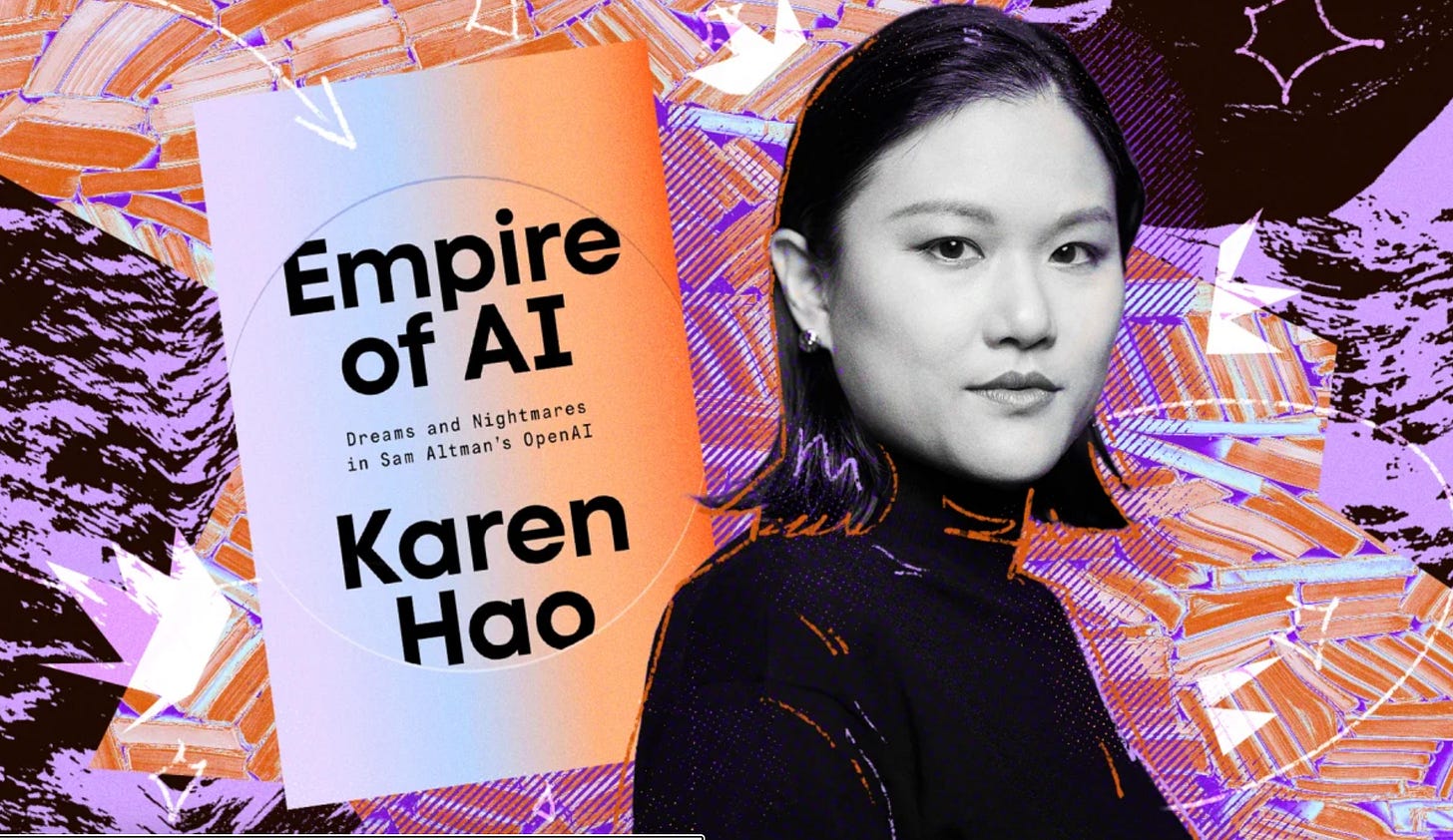

我們將繼續探討凱倫·郝(Karen Hao)的重磅調查報導——《Empire of AI: Dreams and Nightmares in Sam Altman’s OpenAI》。

人物

在我們開始深入章節之前,有必要先了解這本書的份量與其作者的背景。凱倫·郝並非等閒之輩,她曾是《華爾街日報》的記者,後來擔任《麻省理工科技評論》的 AI 高級編輯。

為了撰寫本書,她投入了近七年的時間,進行了超過 300 次的訪談,其中光是 OpenAI 的現任與前任員工就佔了 90 多位。這種驚人的投入,讓本書成為迄今為止對 OpenAI 這家全世界最受矚目的 AI 公司最全面、最深入的調查之一。

本章引言

在上一章對 AI 發展的宏觀歷史進行了反思之後,我們將視角重新聚焦回 OpenAI 內部,探討一個支配了其後所有技術決策的核心思想——「規模化法則」(Scaling Laws)。這個法則的核心信條簡單而粗暴:只要不斷地用更多的數據和更強的算力來擴大神經網絡的規模,更高級的智能就會自然「湧現」。

本章的主角是 OpenAI 的首席科學家伊爾亞·蘇茨克維(Ilya Sutskever)。我們將跟隨他的視角,理解這個看似簡單的信念是如何成為 OpenAI 的北極星。正是在這個信念的驅動下,GPT 系列模型應運而生。然而,當 GPT-2 的強大能力超乎團隊預期時,一場關於「開放」與「安全」的內部大辯論也隨之爆發。這個決定不僅是 OpenAI 的一個關鍵轉折點,也預示著公司將從一個學術性的研究機構,逐漸轉變為一個更懂得如何操控公眾敘事的「玩家」。

章節概要 (Chapter Summary)

本章深入探討了伊爾亞·蘇茨克維 (Ilya Sutskever) 的核心信念——「規模化 (scaling)」是通往 AGI 的唯一路徑。作者追溯了蘇茨克維從一個對深度學習充滿狂熱信念的年輕學生,到成為 OpenAI 研究方向的絕對主導者的歷程。他的核心思想是,智能的本質與大腦的規模相關,因此,只要不斷擴大神經網絡的規模(更多的數據、更多的計算),就能湧現出更高級的智能。這個「規模化法則 (Scaling Laws)」成為了 OpenAI 的指導思想。本章詳細描述了 OpenAI 如何在這一思想的指引下,開發出從 GPT-1 到 GPT-2 的模型,並在內部引發了關於是否應該公開研究成果的激烈辯論。