[讀者回函]:一份「未拆封的禮物」,與台灣 AI 素養發展的關鍵時刻

An "Unopened Gift" and the Turning Point for Taiwan's AI Literacy

2025 年 12 月 23 日,台灣立法院三讀通過了《人工智慧基本法》。這不只是條文通過,更是一個訊號:台灣終於要在 AI 治理的全球競賽中,從「被動適應者」轉向「主動設計者」。

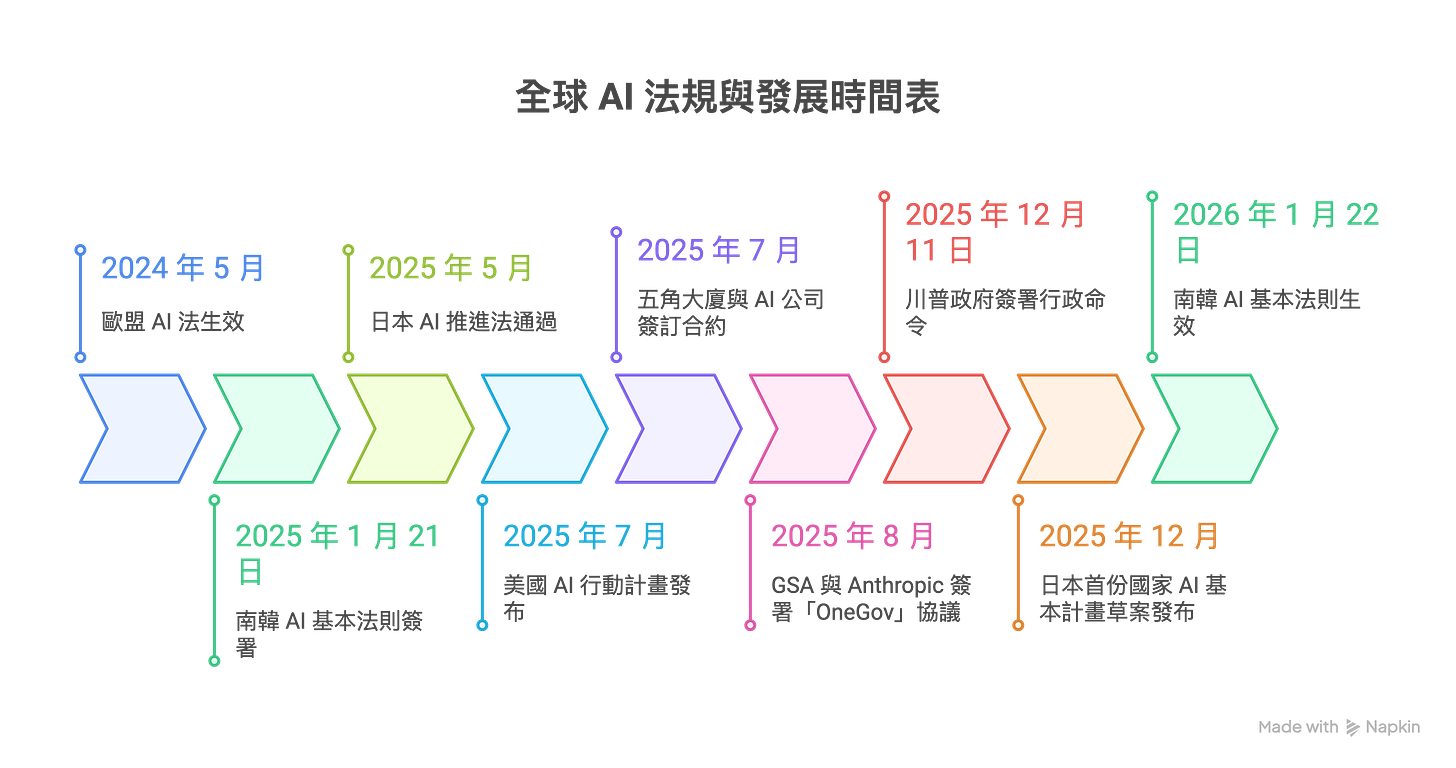

但我想先補充一個全球背景:台灣 AI 基本法通過的同時,全球 AI 治理正在分成四條截然不同的路線。

歐盟的 AI Act 於 2024 年 5 月正式生效後,走的是「高風險預先合規」的嚴格路線。美國則在 2025 年 7 月發布 AI 行動計畫,強調「去除紅帶子」,同月五角大廈向 Anthropic、Google、OpenAI、xAI 各發出 2 億美元合約,8 月總務署 (GSA) 又與 Anthropic 簽署「OneGov」協議,將 Claude 提供給全美政府機構。這不只是創新鼓勵,更是國家級的合約與背書。川普政府甚至在 2025 年 12 月 11 日簽署行政令,試圖推翻州級 AI 法規(如加州的 SB 1047),展現了極致的創新優先姿態。

南韓的 AI 基本法則於 2025 年 1 月 21 日簽署,即將於 2026 年 1 月 22 日正式生效,採用「風險分類 + 事後責任」的中間路線;日本則在 2025 年 5 月通過 AI 推進法,並於 12 月發布首份國家 AI 基本計畫草案,計劃 5 年內投入 ¥1 兆(約 $6.34B)支持,從 2026 財政年度開始衝刺「物理 AI」與國產模型。

這本該是一個值得開香檳慶祝的新年禮物。作為一名長期觀察 AI 治理與隱私權利的寫作者,我卻在條文通過的那一刻,感到一股冷風。這份基本法是一個訊號,標誌著台灣終於想從「被動適應者」轉向「主動設計者」;但我更擔心的,它會不會成為一份「無法拆封的空頭支票」?

想像一下,你收到了一份最先進的 AI 引擎,但包裝這份禮物的膠帶是 20 年前制定的《個資法》,而說明書則是傾向於保護舊時代紙本出版的《著作權法》。這就是台灣目前的困境:我們拿到了一個新引擎,卻沒有給它呼吸的空間。

診斷:被「舊膠帶」掐住脖子的創新理想

讓我們撕開精美包裝,看看裡面的殘酷現實。全球的治理路徑其實分成三類。歐盟用「硬法」——AI 法案預先規定高風險類別、要求嚴格罰則。美國則強調去除監管、鼓勵開源與創新。更進一步地,2025 年 12 月 11 日,川普政府簽署行政令,明確試圖以聯邦權力推翻州級 AI 監管法規,特別針對科羅拉多州的 AI 法,理由是州法要求 AI 系統避免對受保護群體的「差異對待」會導致模型「必須產生虛假結果」。這表明美國的「去除紅帶子」態度已經從產業鼓勵升級到司法對抗。日本選擇了第三條路:軟法。日本的 AI 推進法只是一部「框架法」,宣示政策方向但不對企業施加強硬義務,相信信任與透明度會透過自主指引自然浮現。

讓我先說一個讓我感到寒心的事實。就在基本法通過的半年前(2025 年 6 月 24 日),新北地方法院對台灣法律新創 Lawsnote 做出了一個判決:法院判決其應賠償 NT$154.5 百萬(約 US$4.7M),且駁回了其提出的「合理使用」(fair use) 主張,認為其不當規避投資成本。這起案件不僅涉及鉅額民事賠償,新北地方法院也認定創辦人構成刑事著作權侵害,成為台灣首批因法律資料爬蟲而面臨刑事風險的新創案例。

這個判決冷冰冰地揭示了現狀:在台灣,法律膠帶目前仍緊緊纏繞在既有的商業模式上。 即使基本法宣稱要推動創新,但只要現有的個資法(知情同意困局)與著作權法(合理使用黑洞)不鬆綁,這份禮物就永遠拆不開。我常在專欄提到「一個 AI,兩種命運:從台灣 Lawsnote 到美國 Anthropic,看懂扼殺與扶植創新的法律鴻溝」。這個鴻溝,正在 2026 年的一開頭,變成台灣創業者腳下的深淵。

地緣政治的具體抉擇:你選日本的機器人,還是中國的模型?

你可能會問,為什麼台灣要選這條路?看一眼鄰國的棋棋就很清楚了。

南韓的「數位邊防」:南韓於 2025 年初簽署、即將於 2026 年 1 月 22 日生效的基本法,核心在於極其明確的「風險分類」。

日本的「物理 AI」豪賭:日本 2025 年 12 月發布的基本計畫草案明定 5 年內投入 ¥1 兆。日本政府相信的是:我不立法管你,我還帶頭撒錢讓你衝刺。

美國的「國家級合約」攻勢:美國的扶植機制是靠「直接政府訂單 + 國家級背書」。

這不再是抽象的政治題,而是每一家台灣企業的財務題。想像一家台灣製造廠,現在面臨選擇:是用日本政府背書、專為工廠自動化設計的「物理 AI」?還是用美國 AWS 雲端驅動的通用 AI?2025 年,阿里巴巴的 Qwen 家族與 DeepSeek 系列在 Hugging Face 等開源平台上名列前茅,以完全開源權重與極低推理成本迅速擴散到全球開發者社群。台灣企業要用這套幾乎零成本、但可能涉及數據主權風險的開源模型,還是支付高額代價租用美國的技術主權?基本法給了你框架,但不能替你做生存賽的抉擇。

素養發展的關鍵點:從「工具操作」到「技術主權判斷」

這正是為什麼 2026 年是「台灣 AI 素養」的關鍵時刻。我們過去談素養,談的是「如何下 Prompt」;現在談素養,談的是「決策主權素養」(Decision Sovereignty)。

一個具備 2026 級素養的專業人士,必須具備以下三個判斷力切入點:

模型出身鑑定力:能分辨出這套系統底層是用誰的模型、背後的價值偏見為何?是否在 2025 年新北地院的判決邏輯下具備合規性?

制度免疫力評估:管理者不再問「AI 能做什麼」,而是問「我的組織是否有韌性處理 AI 出錯後的責任歸屬」?

隱私成本權衡力:在醫療或教育領域,能清楚判斷何時該為了「學生主權」或「患者尊嚴」而拒絕使用某些高風險的自動化工具。

公民參與的實踐路徑:如何真正「打開」這份禮物?

如果基本法只留在國科會的辦公室裡,它就是死的。我們需要建立具體的公民參與路徑:

建立「演算法審計社群」:效法網路安全行業,我們需要台灣自己的「AI 白帽偵探」,針對基本法要求的公平性進行壓力測試。

推動「參與式價值評估」:在子法制定過程中,教育部與衛福部應建立讓教師、學生、患者能參與的「價值權衡沙盒」。

建立「決策審計軌跡」標準:要求所有醫療與教育 AI 具備「思考軌跡」,這才是「透明可解釋」的實踐。

台灣醫療與教育 AI 的治理缺口

對台灣的實踐建議:醫療篇

若真要對得起基本法裡「透明與問責」的要求,2026 年台灣在醫療 AI 領域至少要做到三件事:一是強制所有高風險系統保留可以回溯到單一預測的決策 log,並附上 CHAI 式的醫療 model card;二是把「AI 決策標記」嵌回電子病歷與申訴流程;三是在子法裡強制每一個系統明確自我標註是「輔助決策」還是「自動決策」,並對後者要求更嚴格的保險與審查。

技術層:強制「可稽核 log」與系統卡(system card)

規定凡被認定為「高風險醫療 AI」的系統,必須保留可回溯到單一預測的決策紀錄:包含當時使用的模型版本、輸入資料來源類型、關鍵特徵、決策分數與閾值。要求廠商提供「醫療版 model card / system card」,參考 Coalition for Health AI (CHAI) 的 applied model card 格式,清楚寫出適用場景、禁用場景、訓練資料族群分布、已知限制。這些文件不是放官網當 PR,而要納入 TFDA 核可與醫院內部治理流程,出事時可直接對照「當初承諾」與「實際行為」。

流程層:把「AI 決策」嵌回醫療紀錄與申訴流程

要求醫院在電子病歷系統中標記:哪些診斷或建議涉及 AI 輔助,讓醫師與病人事後查得到「這個決定有沒有 AI 參與」。在申訴與醫療爭議處理過程中,將「AI 決策軌跡」納入必調資料,就像現在會調閱醫囑、護理紀錄一樣。UnitedHealth 的訴訟之所以現在必須大規模啟動證據開示,就是因為當初沒有要求這種可追溯紀錄,導致外部無法檢驗 AI 是否實質接管了決策。

制度層:明確「AI 輔助 vs 自動決策」的責任切割

在子法中要求每一個醫療 AI 系統先自我標註:它是「決策輔助」還是「自動決策」。前者由醫師負最終責任,後者必須建立保險或賠償機制,並設定更嚴格的審查門檻。這直接回應 UnitedHealth 案裡的核心爭議:公司一方面說「AI 只是參考」,一方面讓演算法在實務上覆蓋醫師判斷。

對台灣的實踐建議:教育篇

建立「教育 AI 演算法公平性標準」,推動以學生為中心的資料透明度,並加強教師的「AI 倫理批判能力」。

AI 素養的本質:不是「會用 ChatGPT」,而是「能批判 AI」

基本法第 5 條要求「弭平 AI 技能落差」,但這裡有一個關鍵區別:AI 素養 ≠ AI 技能。

我在「公民AI素養實踐指南:從參與機制到信用權益的主動守護」中討論過,真正的 AI 素養包括認知層、評估層與行動層。台灣目前的教育主要在「技能層」,完全缺乏「評估層」與「行動層」。2026 年,如果我們還只關心學生學過 Python,而不是學生能評估 AI 的公平性,我們就錯過了這個時刻。

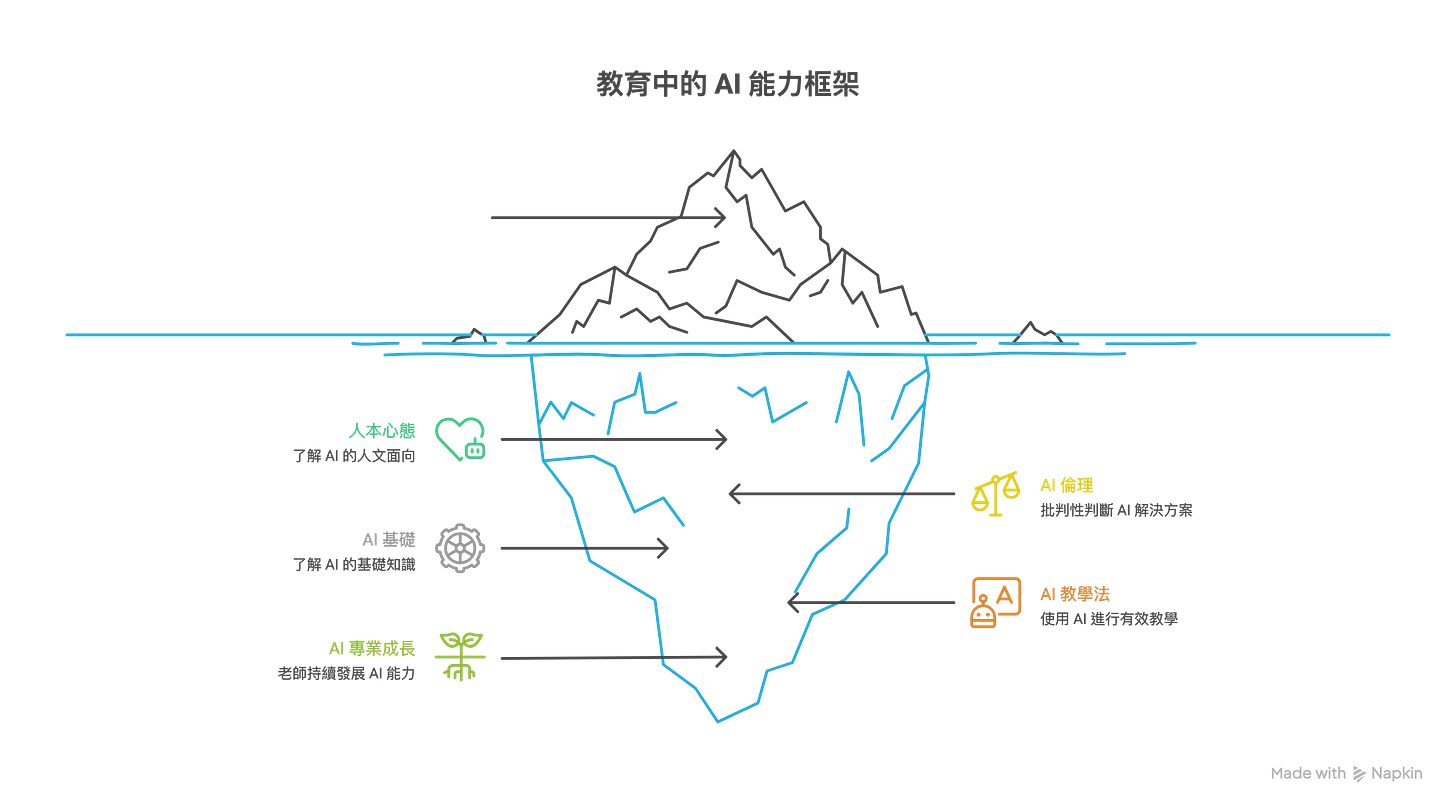

更尖銳的問題是:誰來教這個?大多數台灣教師本身都沒有受過「如何批判性評估 AI」的訓練。UNESCO 在 2024 年推出了「AI Competency Frameworks for Teachers and Students」,明確把「AI 倫理」、「批判性判斷 AI 解決方案」、「理解資料權與偏差」列為教師與學生都必須具備的核心能力。框架為教師設計了 5 大面向、15 項能力與三個進階層級,也為學生規劃了從理解到創造的學習路徑。但到 2025 年底,台灣尚未依據這些框架設計任何全國性的教師培訓或課綱,這就是 2026 年最明顯的制度空白。我們已經有國際公認的參考藍本,但選擇不拿來用,這才是真正讓人不安的地方。

2026,你準備好成為「主動設計者」了嗎?

AI 基本法的通過只是一個訊號,真正的禮物需要我們親手拆開。

給管理者的處方箋: 不要再等待中央給答案。建立你的「AI 專案紅綠燈檢查表」,像我在「AI 轉型不是技術問題,是管理者的認知災難」中建議的那樣,先完成認知升級,再談技術引進。

給設計師與開發者的行動指南: 將 AIPET 框架融入你的工作流。不要只會下 Prompt,要學會設計「可恢復的信任」。如我在「Agentic AI 的 UX 設計:從三大挑戰到 AIPET 系統化策略」中所說,我們需要隨時被人類撤銷、修正的系統。

2026 年國科會的「禮物拆封清單」

台灣 AI 基本法就像一份還沒拆開的禮物。關鍵在於 2026 年國科會是否敢做以下三件事:

子法與風險分類標準(Q1-Q2 2026):發布「AI 應用風險分類指南」,明確定義高低風險。

創新沙盒與豁免機制(Q2-Q3 2026):建立沙盒,允許符合條件的新創臨時豁免某些限制。這是突破「Lawsnote 困局」的唯一路徑。

基礎設施投資與政府採購承諾(Q3-Q4 2026):對標日本與美國的投資額,並給予符合原則的新創採購優先權。

2026 年 AI 治理時間表:誰該在何時交卷?

如果 2026 年底前,這個時間表還有超過一半沒完成,我們就該問:為什麼?是資源不足?還是官僚推動缺乏決心?

給讀者的邀請:成為「禮物監察員」

2026 年,你可以做什麼:

如果你是企業主:在 Q1 詢問國科會你的產品風險等級,並評估加入創新沙盒的可能性。

如果你是教育工作者:在 Q2 詢問教育部素養標準進度,並在校內建立學生資料保護機制。

如果你是公民:追蹤國科會的待辦清單,推薦親友閱讀重要的 AI 倫理觀點,提升集體的「AI 素養」。

這份禮物是政府給台灣社會的,但最終它能否被拆開,取決於我們是否願意追蹤、質疑、與推動。法律本身是中立的,行動才會決定結果。

結語:如果不主動設計,就只能被設計

台灣的地緣位置,注定了我們不能中立。當各國在賽道上狂奔,台灣站在鋼索上。2026 年,我希望見證的是:我們每一個人,如何從這份「未拆封的禮物」中,提取出屬於台灣的人文價值與技術主權。

如果我們不在 2026 年開始主動設計這場生存賽的規則,那麼接下來十年,台灣只能被動扮演別人遊戲裡的配角。

本文引用的 2025 年專欄文章:

Copyright © PrivacyUX Consulting Ltd. All rights reserved.

Joshua 是 Agentic UX(代理式使用者體驗)的先驅,在人工智能與使用者體驗設計領域擁有超過 15 年的開創性實踐。他率先提出將用戶隱私保護視為 AI 產品設計的核心理念,於 2022 年創立 Privacyux Consulting Ltd. 並擔任首席顧問,積極推動隱私導向的醫療 AI 產品革新。此前,他亦擔任社交 AI 首席策略官(2022-2024),專注於設計注重隱私的情感識別系統及用戶數據自主權管理機制。