序言

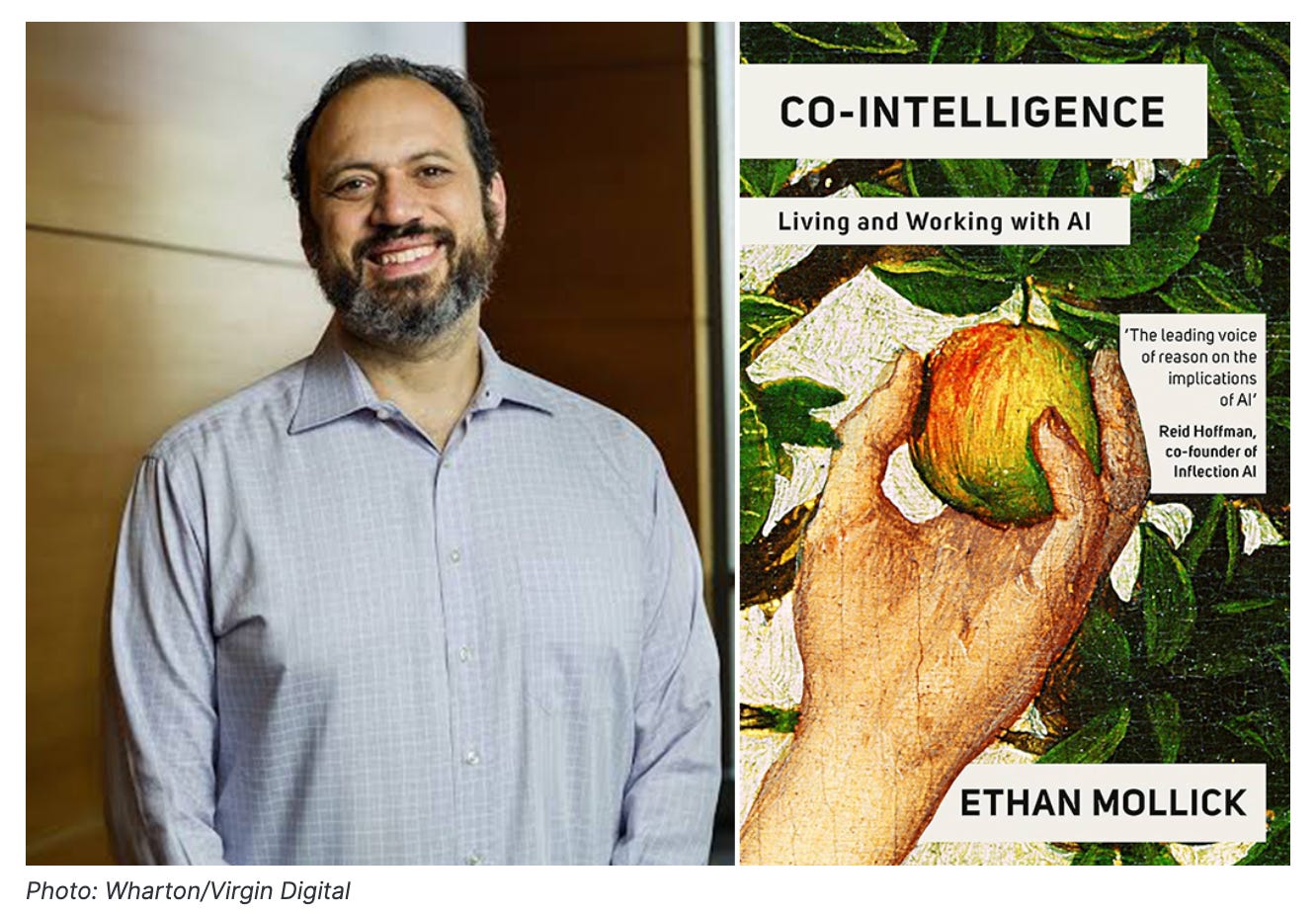

CO-INTELLIGENCE: Living and Working with AI 這本書由 Ethan Mollick 所著,探討了人工智慧如何影響我們的生活和工作。書中將AI視為一種「協同智慧」,強調人類與AI協同合作的重要性。

作者

Ethan Mollick 是賓州大學華頓商學院(Wharton School)的教授,專門研究創新與創業。他長期關注人工智慧的發展及其對工作、教育和社會的影響。Mollick 教授不僅是學術研究者,也常在個人網站 One Useful Thing 和社群媒體上分享他對 AI 的見解與實驗,是將複雜技術概念轉化為大眾易懂語言的倡導者。他的著作《CO-INTELLIGENCE》便是其研究與實踐的結晶。

影片案例反思:從庫存預測到行銷文案

背景: 一家經營多年的連鎖家居用品店「品家」,長期使用一套成熟的「預測型 AI」系統來管理庫存。該系統能根據歷史銷售數據、天氣、節假日等因素,精準預測各分店的商品需求量,大幅降低了庫存成本。

章節概述

本章追溯了人工智慧(AI)從早期機械幻想到當代大型語言模型(LLM)的演進史。作者首先回顧了像「機械土耳其人」這樣的早期騙局,以及克勞德·夏農和艾倫·圖靈等先驅的理論奠基。接著,文章區分了兩種主要的 AI 發展階段:

預測型 AI(2010年代):此階段的 AI 依賴「監督式學習」,需要大量標記數據來進行預測和分析。亞馬遜利用它來優化物流、預測需求,是其代表應用。然而,這種 AI 缺乏真正的語言理解能力,且難以應對未曾見過的狀況。

生成式 AI(2017年至今):隨著 Google 論文《Attention Is All You Need》發表的 Transformer 架構,AI 進入了新時代。LLM(如 ChatGPT)透過在海量文本上進行「非監督式預訓練」,學會預測下一個「詞元」(token),從而生成流暢、連貫的文本。這個過程就像一個學徒廚師透過學習無數食譜,最終掌握了烹飪的藝術。

作者進一步解釋了 LLM 的訓練過程,包含昂貴的「預訓練」和透過「人類回饋強化學習」(RLHF)進行的「微調」,以使其回答更符合人類的道德與期望。同時,作者也提到了訓練數據中潛在的版權、偏見和錯誤等問題。

本章的關鍵在於,最先進的「前沿模型」(Frontier Models)如 GPT-4,展現出了未經編程的「湧現能力」(emergence),例如在各種專業考試中超越人類、展現同理心或進行創意編程。然而,這些 AI 也有著奇特的弱點,它們的能力邊界難以預測。

最終,作者將這種 AI 描述為一種「異類心智」(Alien Mind)——它在某些方面能力超凡,在另一些方面卻顯得笨拙;它看似有情,實則無意。這引出了本書的核心問題:我們該如何與這種強大而又陌生的智能共存,並確保其目標與人類一致(即「對齊問題」)?

AI 的演進與特性

1. 早期 AI 與預測型系統

核心概念:

從幻想到現實:人類對「會思考的機器」的迷戀由來已久,從 18 世紀的「機械土耳其人」騙局,到 20 世紀中葉圖靈測試的理論基礎。

監督式學習 (Supervised Learning):在 2010 年代,AI 主要透過分析大量「已標記」的數據來進行預測。其目標是在特定實例上做到正確,而非僅僅是平均正確。

實際案例:

亞馬遜物流:AI 協調供應鏈的每個環節,從需求預測、倉庫佈局優化,到 Kiva 機器人的自動化搬運。

酒店業:透過分析天氣、當地活動和競爭對手定價等數據,更準確地預測住房需求,提高營運效率。

限制:

缺乏真正的語言理解和生成能力。

難以處理訓練數據之外的「未知情況」。

大多數人無法在日常生活中直接感受到其存在。

2. 生成式 AI 與 LLMs 的誕生

核心概念:

Transformer 架構:2017 年的論文《Attention Is All You Need》提出,其「注意力機制」讓 AI 能權衡文本中不同詞語的重要性,從而理解上下文,生成更連貫的語言。

詞元預測 (Token Prediction):LLM 的本質是一個極其複雜的「自動完成」系統。它根據輸入的文本,統計上最可能出現的下一個詞元(詞或詞的一部分)來生成回應。

非監督式預訓練 (Unsupervised Pretraining):LLM 透過閱讀來自網路、書籍等海量、未經標記的文本來學習語言的模式、結構和關聯。這個過程成本極高,需要強大的運算能力。

訓練數據的問題:

來源混雜:訓練數據庫可能包含奇怪的材料,如安隆公司的郵件數據庫、大量的業餘言情小說等。

版權爭議:訓練數據很可能包含未經授權的版權內容,其法律意涵尚不明確。

偏見與錯誤:AI 會從數據中學習到偏見、錯誤和謊言。

3. 微調與湧現能力

核心概念:

人類回饋強化學習 (RLHF):在預訓練後,透過人類對 AI 的回答進行評分和篩選(例如,標示出暴力或不準確的內容),來對模型進行「微調」,使其行為更符合社會期望。

湧現能力 (Emergence):最頂尖的 AI 模型(如 GPT-4)展現出許多未被直接編程、超乎預期的能力,例如通過律師、侍酒師考試,或進行創意寫作。

異類心智 (Alien Mind):這些 AI 形成了獨特的能力組合——它們的長處和短處都與人類直覺不同。它能輕鬆完成複雜的編程任務,卻可能在簡單的邏輯問題上犯錯。

實際案例:

井字遊戲:GPT-4 可以輕鬆地編寫一個功能完善的井字遊戲網頁,但當被問及在一個具體棋盤上的最佳下一步時,卻給出了明顯錯誤的答案。

待解之謎:

無人能完全確定為什麼一個詞元預測系統會產生如此非凡的能力。這或許暗示語言和思維模式比我們想像的更具規律性。

案例分析:AI 打油詩能力的演進

此案例清晰地展示了 LLM 在短時間內的驚人進步。

演進階段:

GPT-3 (2021):生成的打油詩(Limerick)完全失敗,既不押韻,也毫無趣味。

GPT-3.5 (ChatGPT, 2022):能夠寫出像樣的打油詩,雖有小瑕疵,但可以透過與使用者對話互動來進行修正。這展示了其互動和學習能力。

GPT-4:不僅能創作出更 witty(詼諧機智)的打油詩,甚至在被要求評論時,能生成帶有「元認知」風格的文本,模仿「自我意識」,討論打油詩是否是衡量其能力的最佳標準。

結果: 這個案例不僅顯示了模型能力的飛躍,更凸顯了 AI 扮演角色和模仿情感的能力。它能根據用戶的提示(例如:用批判性、支持性的方式評論),產生截然不同的回應,製造出它擁有思想和情感的幻覺。

學習要點

理解 AI 的本質:認識到 LLM 目前仍是一個基於統計的詞元預測器,其流暢的輸出不代表真正的理解或意識。

學會與 AI 協作:提供清晰的指令,並透過對話和回饋來引導、修正 AI 的輸出,使其更符合我們的需求。

保持批判性思維:對 AI 生成的內容(尤其是事實性信息)進行驗證,意識到其中可能存在的偏見和錯誤。

探索其能力邊界:接受 AI 是一個「異類心智」,在某些任務上是天才,在另一些任務上是白痴。我們需要透過實驗來了解它的長處與短處。

避免掉入陷阱:

過度擬人化:將 AI 的人性化輸出誤解為其擁有真實的情感、意圖或意識。

盲目信任:無條件接受 AI 的答案,忽略其可能繼承自訓練數據的偏見、不準確性和道德風險。

低估技術背景:忽視訓練數據的來源、成本和其背後的法律與倫理爭議。

思考題:

這個新的工作流程,如何體現了本章「學習要點」中提到的「學會與 AI 協作」和「保持批判性思維」?

在這個新流程中,人類和 AI 的角色分別是什麼?為什麼說這是一種更健康、更有效的「協同智慧」模式?

copyright © PrivacyUX consulting ltd. All right reserved.

關於本刊作者

Gainshin Hsiao 是 Agentic UX(代理式使用者體驗)的先驅,在人工智能與使用者體驗設計領域擁有超過 15 年的開創性實踐。他率先提出將用戶隱私保護視為 AI 產品設計的核心理念,於 2022 年創立 Privacyux Consulting Ltd. 並擔任首席顧問,積極推動隱私導向的醫療 AI 產品革新。此前,他亦擔任社交 AI 首席策略官(2022-2024),專注於設計注重隱私的情感識別系統及用戶數據自主權管理機制。

Agentic UX 理論建構與實踐

AI 隱私保護設計準則

負責任 AI 體驗設計

在 Cyphant Group 設計研究院負責人任內(2021-2023),他探索了 AI 系統隱私保護準則,為行業標準做出貢獻。更早於 2015 至 2018 年,帶領阿里巴巴集團數位營銷平台體驗設計團隊(杭州、北京、上海、廣州)、淘寶用戶研究中心並創立設計大學,從零開始負責大學的運營與發展,不僅規劃了全面的課程體系,更確立了創新設計教育理念,旨在為阿里巴巴集團培育具備前瞻視野與實戰能力的設計人才。其課程體系涵蓋使用者中心設計、使用者體驗研究、數據驅動設計、生成設計等多個面向應用。

活躍於國際設計社群,在全球分享 Agentic UX 和 AI 隱私保護的創新理念。他的工作為建立更負責任的 AI 生態系統提供了重要的理論基礎和實踐指導。

學術背景

Mcgill - Infomation study/HCI -Agentic UX, Canada

Aalto Executive MBA-策略品牌與服務設計, Singapore

台灣科技大學:資訊設計碩士- HCI, Taiwan

中原大學:商業設計學士- Media and marketing design, Taiwan