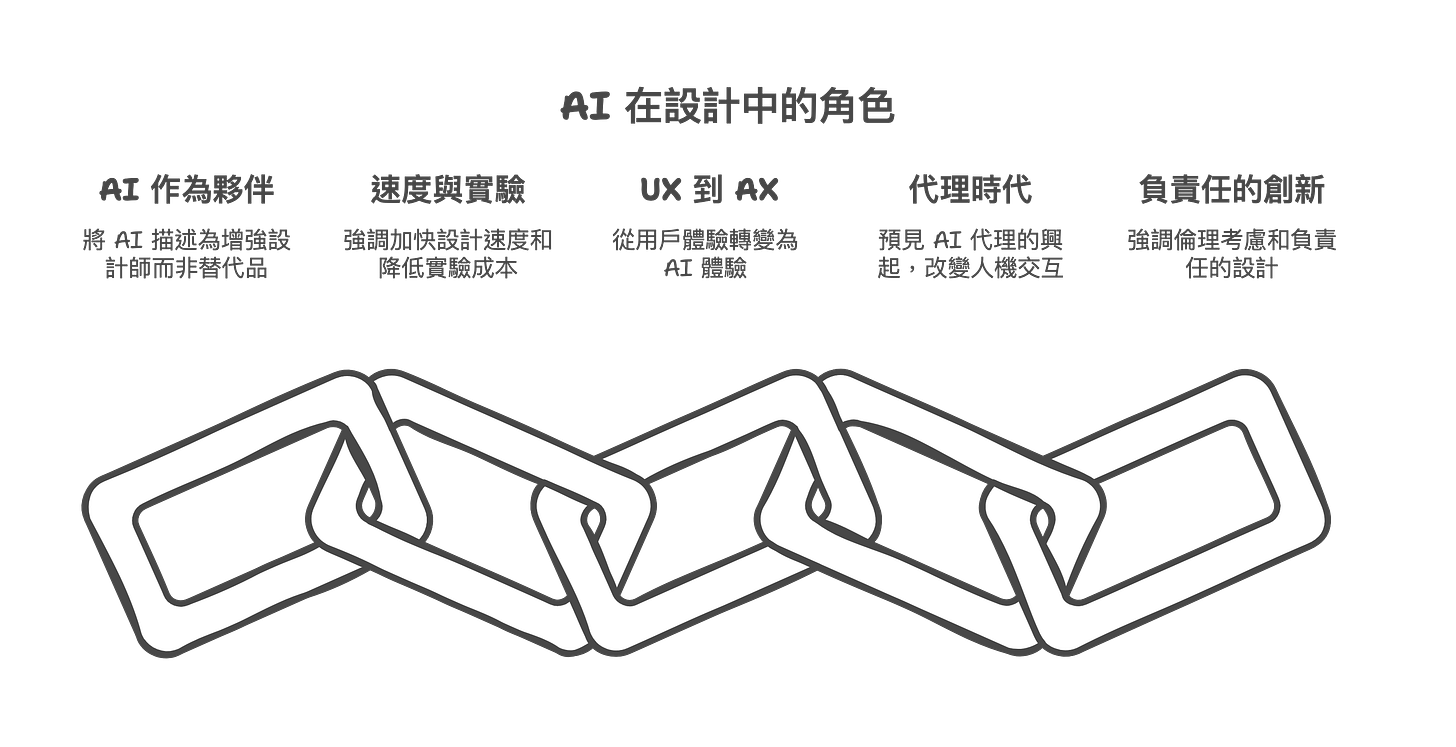

本文摘要 John Maeda 關於 2025 年設計與技術報告作為討論的基礎之一,探討人工智能(AI)如何改變設計領域,而非取代設計師。該報告不僅涵蓋了 AI 實驗成本降低、速度加快,「Agent 時代」的來臨、使用者體驗(UX)向人工智能體驗(AX)的演變,以及負責任地使用 AI 的重要觀點。影片中還分享了關於人類適應性、開源 AI 的成長,以及 AI 使用者體驗最佳實踐的見解。

2015~2024 過往所有報告

人物

約翰·前田 (John Maeda)

是一位著名的美籍日裔設計師、技術專家、作家和教育家。他以在數位媒體和設計領域的工作而聞名,曾擔任羅德島設計學院 (RISD) 院長,並在麻省理工學院媒體實驗室擔任要職。他是創意領導力和設計教育領域的重要人物。他的職業生涯亮點包括在 Automattic 擔任技術專家,並撰寫了多本關於設計和技術的書籍(如《簡單的法則》),強調藝術與工程融合的重要性。他極大地影響了科技行業,倡導在現代設計實踐中融合技術、追求簡約和創新。

對 AI 的主要觀點:

AI 作為夥伴而非替代品: John Maeda 認為 AI 不會取代設計師,而是作為強大的工具和合作夥伴,增強人類的創造力,處理重複性任務,讓設計師專注於更高層次的策略和創意。

速度與實驗: AI 極大提高了設計和開發的速度,降低了實驗成本,使得快速迭代和探索新可能性成為常態。

從 UX 到 AX: 隨著 AI 的普及,用戶體驗 (UX) 正在演變為人工智能體驗 (AX),設計師需要學習如何設計與 AI 協作的界面和體驗。

代理時代 (Age of Agents): 他預見到一個 AI 代理將代表用戶執行任務的時代,這將改變人機交互的模式。

負責任的創新: 強調在擁抱 AI 帶來的機遇時,也要關注其倫理影響,負責任地進行設計和開發。

AI 素養:掌握未來設計與技術的關鍵

理解 AI 的本質:AI 是工具,而非取代者

報告明確指出,AI 的發展趨勢是 改變設計師的工作方式,而不是取代設計師。提升 AI 素養的第一步,就是要破除「AI 威脅論」,將 AI 視為可以 增強人類設計能力的工具。

如同過往的科技變革,AI 的出現是為了 提升效率、拓展可能性,設計師需要學習如何 駕馭 AI,將其融入設計流程,創造更卓越的作品。

John Maeda 反覆強調 AI 不會奪走設計師的飯碗,而是從根本上 重塑設計師的工作流程與核心價值。這並非空泛的安慰,而是基於對技術演進的深刻洞察。提升 AI 素養的首要任務,便是摒棄對未來的恐懼,認識到 AI 的真正角色是 強大的協作夥伴與效率倍增器。想像一下,過去需要數小時甚至數天才能完成的繁瑣任務,如生成多種設計草案、進行大規模圖像尺寸調整、編寫前端基礎代碼、或是從用戶數據中初步提取模式,現在 AI 可以在短時間內高效完成。這意味著設計師能將寶貴的時間與精力,從重複性的勞動中解放出來,更專注於那些機器難以企及的領域:深度用戶同理心、複雜問題的定義與策略規劃、獨特的創意構思、跨領域的整合思考、以及對 AI 產出結果的批判性評估與品味把關。AI 如同設計師的「超級助理」或「副駕駛」,能夠快速探索可能性、驗證假設,但最終的方向盤仍掌握在設計師手中。歷史上,計算機輔助設計(CAD)並未取代建築師,反而讓他們能實現更複雜宏偉的設計;同樣地,AI 將賦能設計師,讓他們能夠應對更複雜的挑戰,創造前所未有的用戶體驗。關鍵在於設計師是否願意 主動學習、擁抱變化,掌握駕馭 AI 的能力,將其無縫整合到創作流程中,從而提升自身的競爭力與不可替代性。設計師無需過度擔憂被取代,更應思考如何利用 AI 放大自身價值。

擁抱「代理時代」:理解 AI 代理的概念

報告強調我們正進入 「代理時代」,這意味著 AI 將以 「代理」 的形式更深入地參與到我們的生活和工作中。理解 AI 代理的概念,包括其能力、局限性以及運作模式,是提升 AI 素養的重要一環。

AI 代理不再只是被動地執行指令,而是可以 主動思考、規劃、甚至與其他代理協作。理解這一點,有助於我們更好地 設計與 AI 協作的工作流程,並 開發出更智慧的 AI 應用。

深入闡釋: 報告中提出的 「Agent時代」 是一個核心概念,預示著 AI 將不再僅僅是執行單一指令的工具,而是進化為能夠 代表用戶或系統,主動執行複雜任務、進行規劃決策、甚至與其他 AI 代理協同工作的智能體。理解 AI 代理的運作模式、能力邊界及其潛在的缺陷,是未來設計與技術人員的必備素養。

特別提到 「代理錯誤的重要性」,這並非鼓勵錯誤,而是強調從錯誤中學習的價值。當一個 AI 代理在執行任務時出錯,無論是理解偏差、規劃失誤還是執行失敗,都暴露了其模型的局限性、潛在的偏見,或是對複雜現實情境理解的不足。分析這些錯誤,對於 迭代改進代理的設計、設定更合理的預期、以及建立必要的人類監督與干預機制 至關重要。此外,影片也解釋了 「循環(loop)」如何賦予代理強大的能力。這通常指代理能夠根據環境反饋或自身評估,不斷調整策略、修正行動的閉環過程(例如結合思考與行動的 ReAct 框架)。

這種迭代循環使得代理能夠處理更長遠、更動態的任務,展現出初步的「智能」。對設計師而言,這意味著未來可能需要設計 代理的目標、行為準則、交互邊界,以及人類如何與這些自主性日益增強的代理進行有效協作的界面與體驗。我們需要思考,當用戶通過代理與世界互動時,設計的焦點將如何從傳統的圖形界面轉向對話設計、意圖理解和信任建立。理解代理的潛力與風險,是駕馭這個新時代的關鍵。從 UX 到 AI/UX:關注 AI 體驗

傳統的 使用者體驗 (UX) 設計,其核心在於優化人與靜態或預定介面之間的互動流程,追求效率、易用性和滿意度。然而,隨著人工智慧的崛起,特別是具備自主學習和決策能力的 AI 系統日益普及,傳統 UX 的範疇顯得捉襟見肘。我們正經歷一場深刻的轉變,從僅僅關注介面互動的 UX,邁向更為複雜和動態的 人工智慧體驗 (AX)。這不僅是術語的演變,更是設計思維的根本性拓展。影片中明確指出了 使用者體驗 (UX) 向人工智慧體驗 (AX) 的演變 這一趨勢,標誌著設計領域需要應對的新挑戰。

AX 的核心,是將焦點從「介面」轉向「智慧體本身」。它不僅關乎使用者如何 操作 AI,更關乎使用者如何 感知、理解、信任並與之協作 的整體經驗。AI 不再僅僅是一個被動的工具,它可能是一個主動的建議者、一個自主的執行者,甚至是一個學習型的合作夥伴。因此,AX 設計需要深入探討:AI 的「個性」或行為模式是否符合使用者預期?AI 的決策過程是否足夠透明,讓使用者能夠理解其「思考」邏輯?使用者如何有效地引導、糾正或否決 AI 的行為?當 AI 犯錯時(這是不可避免的),使用者體驗如何優雅地處理這種失敗,並維持使用者的信任?這些都是傳統 UX 較少觸及的深層次問題。

設計更友善的 AI 介面是 AX 的一部分,但遠非全部。例如,從繁瑣的圖形介面轉向更貼近人類溝通方式的自然語言互動,確實能降低使用門檻。然而,真正的挑戰在於 設計 AI 的「可理解性」(Understandability) 和「可信賴性」(Trustworthiness)。這涉及到 AI 的「可解釋性」(Explainability) 設計——如何以使用者能懂的方式,揭示 AI 作出某個判斷或推薦的原因?這可能需要創新的視覺化方法、簡潔的語言解釋,或是提供不同層次的細節供使用者探索。同時,也需要設計有效的反饋機制,讓使用者能夠感知 AI 的學習進度、不確定性或潛在偏見。確保 AI 的行為符合倫理規範,尊重使用者隱私,避免歧視性輸出,更是建立長期信任的基石,這與後續提到的「負責任地使用 AI」緊密相連。

John Maeda 在報告中強調,我們需要 「為 Agent 創造使用者體驗」。這直接呼應了「Agent時代」的來臨。當 AI 代理被賦予越來越多的自主權,代表使用者執行複雜任務時(例如管理財務、預訂行程、甚至參與創意設計),我們如何設計與這些「數位管家」或「智慧助手」的互動模式?這不再是簡單的按鈕點擊或表單填寫。我們需要設計委派任務的流程、監控代理執行狀況的儀表板、處理異常情況的機制,以及最重要的——建立使用者對代理的控制感和信任感。

如果使用者不信任代理能可靠地、符合其意願地完成任務,那麼再強大的 AI 技術也難以發揮價值。AX 設計師必須思考,如何讓使用者感覺自己始終是最終的決策者,即使在與高度自主的 AI 協作時也是如此。這需要設計師不僅理解人機互動原則,更要理解 AI 代理的潛在能力、局限性以及可能出現的非預期行為,從而設計出既賦能又安全的互動體驗。其中一個有趣的觀察是:「AI 的用戶界面基本上是它不想要用戶界面,它喜歡命令行」。這並非說 AI 真的有偏好,而是一個生動的比喻,說明 AI 的底層邏輯和運作方式,往往是基於複雜的數據流和算法指令,更接近程式設計師熟悉的命令行或 API 交互,而非普通使用者習慣的圖形化介面。這揭示了 AX 設計的核心挑戰之一:如何將 AI 強大但「原始」的能力,轉化為普通使用者能夠輕鬆理解、掌握和利用體驗設計師的角色,就像翻譯官和橋樑,需要在 AI 的原生「語言」(數據、算法、概率)與人類的直觀需求(視覺化、自然語言、簡單操作)之間進行轉化。

我們不能期望使用者去適應 AI 的「命令行」,而必須設計出能夠「隱藏複雜性」的介面和互動方式,讓使用者感覺 AI 是自然、易用且強大的。這可能意味著需要發明全新的互動範式,超越傳統的 WIMP(視窗、圖標、菜單、指針)模型,探索語音、手勢、甚至腦機接口等更自然的交互方式,同時也要確保這些互動能夠有效地駕馭 AI 的複雜能力。

例如,設計一個圖像生成 AI 的 AX,不僅要提供簡單的文本輸入框,可能還需要設計視覺化的風格控制、迭代歷史追蹤、結果可解釋性說明(為何生成此圖像而非彼圖像),以及讓使用者能夠方便地對結果進行微調或反饋的機制。AX 的終極目標,是讓 AI 的力量無縫融入人類的生活和工作流程,增強我們的能力,而不是增加我們的認知負擔或帶來無法預料的風險。

負責任地使用 AI:倫理與風險意識

隨著 AI 能力的提升,負責任地使用 AI 變得至關重要。提升 AI 素養也包括培養 倫理意識和風險意識。這不僅僅是技術層面的考量,更是關乎社會公平、使用者福祉和品牌信譽的根本問題。

我們需要深入思考如何 避免 AI 的偏見和誤用。AI 模型是基於數據訓練的,如果訓練數據本身存在偏見(例如,性別、種族、文化偏見),那麼 AI 生成的設計方案、推薦內容甚至使用者介面,都可能複製甚至放大這些偏見,導致某些群體被邊緣化或受到不公平對待。設計師必須具備識別和緩解這些偏見的能力,確保 AI 工具的應用是包容和公平的。此外,AI 的強大能力也可能被用於惡意目的,例如生成誤導性信息、侵犯版權或進行大規模監控,設計師在開發和應用 AI 時,必須警惕這些潛在的誤用風險。

保護使用者隱私 是另一個核心議題。許多 AI 應用需要收集和分析大量使用者數據來提供個性化體驗或優化設計。然而,這也引發了嚴重的隱私擔憂。如何以透明、合乎道德的方式收集、儲存和使用數據?如何確保使用者對自己的數據擁有控制權?設計師在設計 AI 驅動的產品和服務時,必須將隱私保護作為首要原則,採用「設計即隱私」(Privacy by Design) 的方法。

最終目標是 確保 AI 的發展符合人類的價值觀。這意味著 AI 的設計和應用應該以人為本,尊重人的尊嚴、自主性和權利。我們需要建立清晰的倫理準則和問責機制,確保 AI 的發展方向與社會的長遠利益一致。影片中提到對 「失去控制」 的擔憂,特別是在 AI 代理日益自主化的趨勢下,這種擔憂更顯迫切。國際間關於 AI 安全的討論,正是為了應對這種潛在風險,確保 AI 始終是服務於人類福祉的工具,而不是反過來控制或損害人類。設計師作為人機交互的塑造者,在這一過程中扮演著關鍵角色,需要不斷反思技術的倫理影響,引導 AI 朝著負責任、有益的方向發展。

持續學習與適應:擁抱 AI 的快速發展

AI 技術正以驚人的速度發展,其演進速度遠超以往任何技術革命。因此,持續學習和適應 不再是一種選擇,而是提升 AI 素養、保持專業競爭力的關鍵。設計師不能滿足於掌握某個特定的 AI 工具或平台,因為新的模型、技術和應用場景幾乎每天都在湧現。

報告中提到 開源 AI 的蓬勃發展,這是一個重要的趨勢。正如影片中數據所顯示的,GitHub 上的人工智能存儲庫數量呈指數級增長,從幾年前的數萬個激增至數百萬個。這種開源浪潮極大地降低了接觸和使用先進 AI 技術的門檻,為設計師提供了前所未有的學習資源和實驗工具。無論是圖像生成、程式碼輔助、數據分析還是自然語言處理,都有大量的開源模型和工具可供探索。這意味著 「現在是使用人工智能編碼的最佳時機」,或者更廣泛地說,是學習和應用 AI 的最佳時機,因為有海量的資源可供學習和借鑒。

然而,資源的豐富也帶來了挑戰。如何在海量的信息和工具中進行有效篩選?如何判斷哪些技術真正適用於自己的工作流程?這就需要設計師培養 批判性思維和自主學習能力。我們應該 保持開放的心態,積極探索新的 AI 工具和技術,勇於嘗試將它們應用到實際的設計項目中,哪怕只是小規模的實驗。同時,也要學會評估這些工具的有效性和局限性。更重要的是,需要不斷 更新自己的知識體系,理解 AI 的基本原理、發展趨勢以及不同技術的適用範圍。

這可能需要投入額外的時間學習新知識,參與線上課程、閱讀研究報告、加入相關社群,與同行交流經驗。擁抱 AI 的快速發展,意味著接受一種持續學習、不斷迭代的職業狀態,將學習本身內化為設計工作的一部分。

理解 AI 的局限性:評估與測試的重要性

儘管 AI 能力強大,但它並非萬能,更非完美。理解 AI 的局限性 是提升 AI 素養不可或缺的一環。盲目信任 AI 的輸出結果,而不進行審慎的評估和測試,可能會帶來嚴重的後果。報告強調了 評估和測試 AI 系統 的必要性,這是確保其 可靠性、準確性和安全性 的基礎。

AI 可能會犯各種錯誤。例如,大型語言模型可能會產生「幻覺」(Hallucination),即生成看似合理但事實上完全錯誤或無意義的內容。圖像生成模型可能無法準確理解複雜的空間關係或物理常識。

AI 系統也可能繼承訓練數據中的偏見,導致輸出結果帶有歧視性。影片中展示了 評估數學問題的例子,這類邏輯推理任務正是目前許多 AI 模型的短板所在,它們可能給出錯誤的答案,或者以看似正確的步驟推導出錯誤的結論。在設計領域,AI 可能會生成不符合品牌規範的視覺元素,提出不切實際的用戶流程建議,或者錯誤地解讀用戶研究數據。因此,提升 AI 素養也包括學習如何 評估 AI 模型的輸出結果。這需要設計師具備批判性眼光,不能全盤接受 AI 的建議。需要學習如何 辨識 AI 可能犯的錯誤,例如事實錯誤、邏輯謬誤、潛在偏見、創意平庸等。更進一步,需要 建立有效的評估機制,這可能包括交叉驗證、用戶測試、專家評審等多種方法。在設計工作流中引入 AI 時,必須設定清晰的質量標準和驗收流程。

影片中提到 「評估測試對這些人工智能技術如此重要,因為你不想損害你的品牌」。這點至關重要。一個未經充分測試的 AI 設計工具,如果生成了低質量、有冒犯性或者侵犯版權的內容,並被應用到最終產品中,將嚴重損害用戶體驗和品牌聲譽。因此,設計師不僅要學會使用 AI,更要學會質疑 AI、測試 AI,確保 AI 的應用真正提升設計質量和用戶價值,而不是帶來新的風險。人類的判斷力、審美觀和對複雜情境的理解,在評估和指導 AI 方面仍然是不可替代的。

人機協作:發揮人類的獨特價值

在 AI 時代,人機協作 將成為常態。提升 AI 素養不僅是為了更好地使用 AI 工具,更是為了 發揮人類的獨特價值。AI 不應被視為威脅,而是一個強大的合作夥伴,能夠處理繁瑣任務,讓我們專注於更高層次的策略思考、創意發想與倫理把關。

報告中提到,人類的創造力、品味、情感和倫理判斷 是 AI 無法輕易複製的核心能力。AI 或許能生成看似創新的內容,但真正的品味、深刻的情感連結以及符合社會價值的倫理判斷,仍需人類的智慧來引導。我們應該 專注於提升這些人類獨有的能力,學習如何有效地與 AI 協作,讓技術服務於人類的目標,共同創造更美好的未來。

例子: 影片中明確指出,面對 AI 增強的未來,人類必須具備適應能力。這不僅僅是被動接受變化,而是主動學習、調整和進化。正如約翰·W·加德納 (John W. Gardner) 在其關於「自我更新」(Self-Renewal) 的論述中所強調的,個人和社會都需要不斷擺脫僵化的思維和行為模式,擁抱變化,持續探索和學習新事物,避免陷入停滯。在 AI 技術日新月異的今天,這種自我更新的精神顯得尤為重要。我們不能滿足於現狀,害怕被淘汰,而應將 AI 視為自我提升和拓展能力的契機,不斷學習如何與這些新工具共存共榮。加德納提醒我們,探索、風險承擔和對失敗的容忍是保持活力的關鍵,這正是我們在應對 AI 變革時所需要的態度。

這種適應與協作體現在多個方面。例如,AI 可以像影片中提到的那樣,協助產品經理使用 ChatGPT 製作 PRD (產品需求文件),讓他們從繁瑣的文檔工作中解放出來,更專注於產品策略和用戶洞察,從而在自己的專業領域變得 更加強大。這並非取代,而是 賦能 (empowerment),讓人們能更有效地發揮其核心技能。另一個例子是 利用 AI 生成圖像或程式碼,如在 p5js 中渲染圖像。這個過程的核心仍然是 人類引導計算如何工作,人類設定目標、提供創意方向、評估結果,AI 則作為高效的執行者。這是一種 「手工 AI」(handcrafted AI) 的概念,強調人類在創作過程中的主導地位和精妙技藝,即使工具變了,人類的創造意圖和指導作用依然是核心。

然而,過度依賴 AI 而缺乏人類的積極參與和批判性思考,可能導致 「被動損失」(passive loss),使我們的技能退化,甚至變得 懶惰。影片中提到自動駕駛的例子,儘管技術進步,但在 惡劣條件、複雜系統交互以及法律和道德困境 面前,人類的判斷和介入仍然不可或缺。Level 5 的完全自動駕駛承諾了很久,但現實中的複雜性,如感測器在惡劣天氣下的失效風險、導航風險、系統複雜性以及難解的法律和道德問題(例如,事故中的責任歸屬),都凸顯了人類監督和決策的重要性。

同樣地,在設計領域,我們不能盲目接受 AI 的輸出。設計師需要運用自己的 品味、經驗和對用戶的理解 來篩選、修改和完善 AI 生成的內容,確保最終成果符合品牌調性、用戶需求和倫理標準。這也解釋了為何 評估和測試 AI 系統 如此重要,不僅是為了技術上的準確性,更是為了維護品牌聲譽和用戶信任,避免潛在的損害。因此,人機協作的關鍵在於 發揮各自的優勢。AI 擅長處理數據、模式識別和快速執行,而人類則擁有 創造力、同理心、批判性思維、複雜問題解決能力和倫理決策能力。設計師的角色正在從單純的「創作者」轉變為「引導者」、「策展人」和「倫理把關者」。我們需要學習如何 有效地「提示」(prompt) AI,如何 評估和迭代 AI 的輸出,以及如何在 AI 的輔助下,將我們的 獨特洞察和創意願景 轉化為現實。

正如比爾·巴克斯頓 (Bill Buxton) 所強調的設計原則——「從人開始」(Start with people),即使在 AI 時代,技術的發展最終也應回歸到人的需求和價值。最終,AI 時代的成功,不僅取決於技術的進步,更取決於我們 如何適應、如何協作,以及如何堅守並發揮生而為人的獨特價值。我們需要像加德納所說的那樣,成為一個能夠不斷學習、不斷適應、不斷 「自我更新」 的個體,才能在 AI 浪潮中乘風破浪,確保技術的發展真正服務於人類福祉。

總結:

提升 AI 素養,不僅是技術專業人士的責任,也是 每個現代公民的必備技能。透過理解 AI 的本質、擁抱 AI 代理、關注 AX、負責任地使用 AI、持續學習與適應,以及發揮人類的獨特價值,我們才能在這個 AI 驅動的時代中 掌握主動權,迎接未來的挑戰與機遇。

copyright © PrivacyUX consulting ltd. All right reserved.

關於本刊作者

Gainshin Hsiao 是 Agentic UX(代理式使用者體驗)的先驅,在人工智能與使用者體驗設計領域擁有超過 15 年的開創性實踐。他率先提出將用戶隱私保護視為 AI 產品設計的核心理念,於 2022 年創立 Privacyux Consulting Ltd. 並擔任首席顧問,積極推動隱私導向的醫療 AI 產品革新。此前,他亦擔任社交 AI 首席策略官(2022-2024),專注於設計注重隱私的情感識別系統及用戶數據自主權管理機制。

Agentic UX 理論建構與實踐

AI 隱私保護設計準則

負責任 AI 體驗設計

在 Cyphant Group 設計研究院負責人任內(2021-2023),他探索了 AI 系統隱私保護準則,為行業標準做出貢獻。更早於 2015 至 2018 年,帶領阿里巴巴集團數位營銷平台體驗設計團隊(杭州、北京、上海、廣州)、淘寶用戶研究中心並創立設計大學,從零開始負責大學的運營與發展,不僅規劃了全面的課程體系,更確立了創新設計教育理念,旨在為阿里巴巴集團培育具備前瞻視野與實戰能力的設計人才。其課程體系涵蓋使用者中心設計、使用者體驗研究、數據驅動設計、生成設計等多個面向應用。

活躍於國際設計社群,在全球分享 Agentic UX 和 AI 隱私保護的創新理念。他的工作為建立更負責任的 AI 生態系統提供了重要的理論基礎和實踐指導。

學術背景

Mcgill - Infomation study/HCI -Agentic UX, Canada

Aalto Executive MBA-策略品牌與服務設計, Singapore

台灣科技大學:資訊設計碩士- HCI, Taiwan

中原大學:商業設計學士- Media and marketing design, Taiwan